微软正尝试在Office中集成国产开源大模型RWKV!

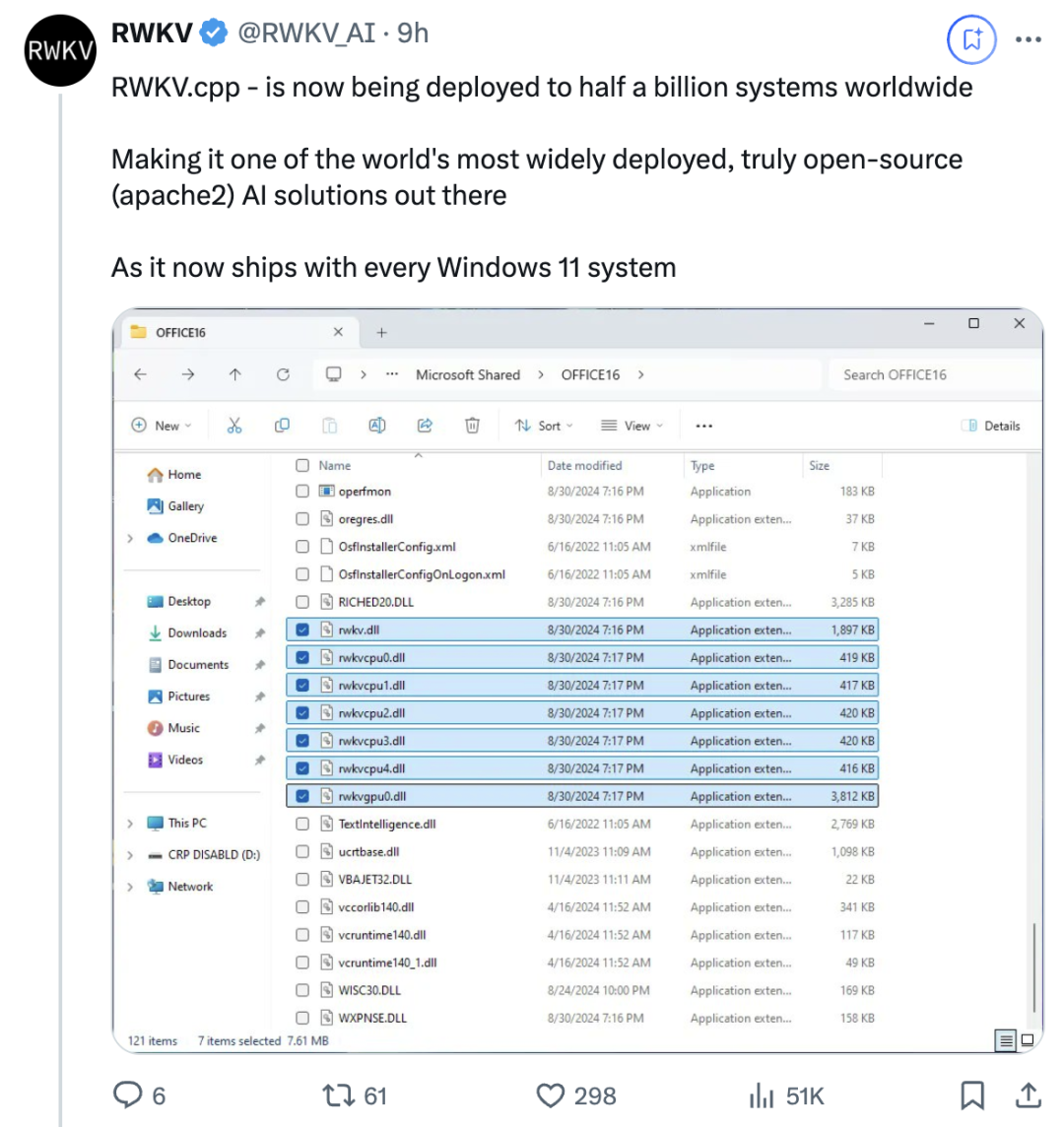

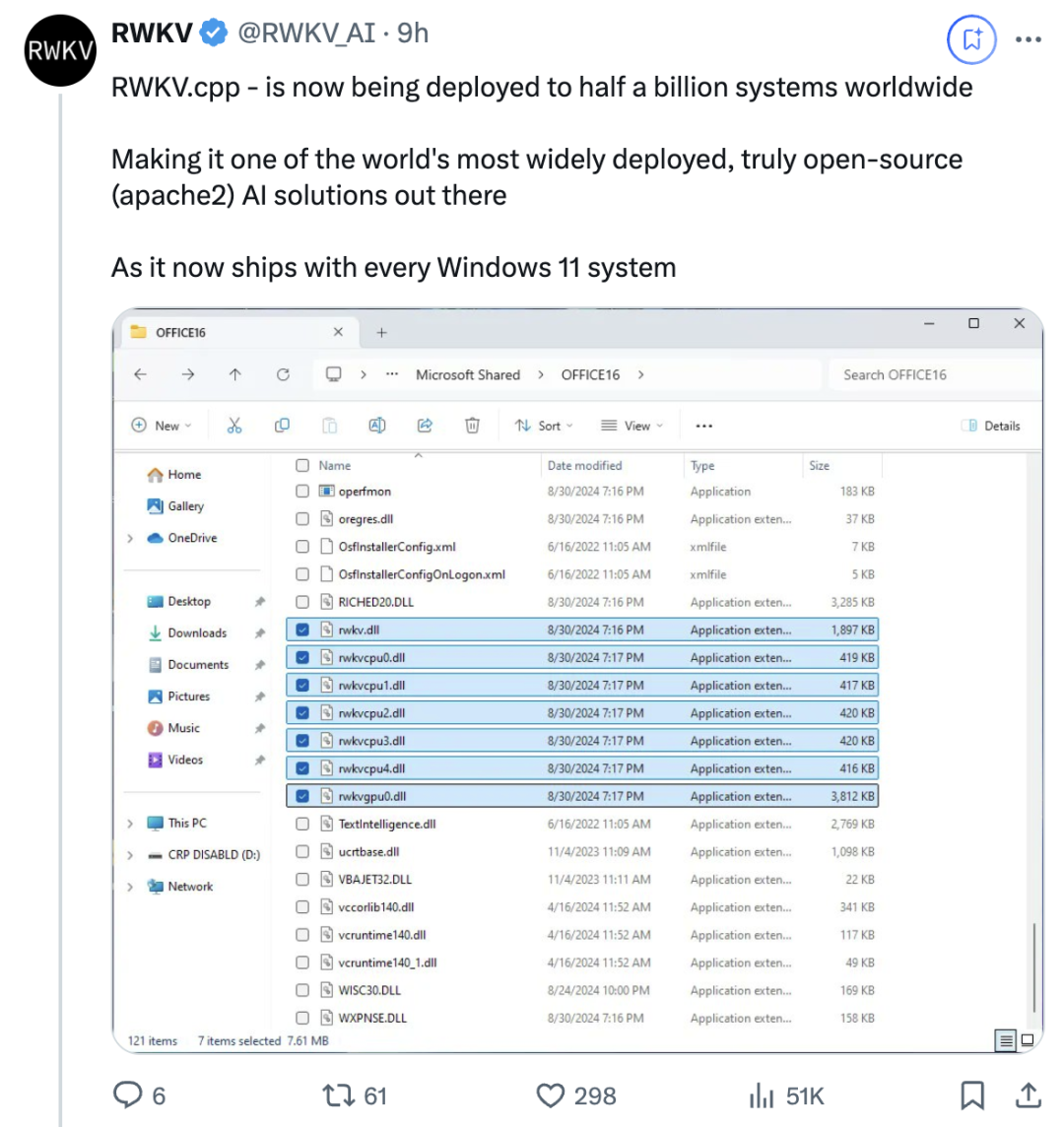

RWKV官方甚至直接发了个推文表示:

RWKV.cpp,现已在全球五亿系统中部署。

之所以这么说,是因为他们发现最新版Windows 11系统的Office文件夹中有以rwkv命名的DLL文件,包含GPU、CPU版本。

对这些二进制文件进行反编译检查,结果发现就是GitHub的RWKV.cpp项目的一种变体。

人人都可以将Windows 11更新到最新版本,通过以下路径自行验证:

C:\Program Files\Microsoft Office\root\vfs\ProgramFilesCommonX64\Microsoft Shared\OFFICE16

或者,也可以在IT商店的任何“copilot Windows 11”设备上搜索系统文件中的rwkv。

消息一出,引发网友热议,不少网友喊微软赶紧打钱。

如果他们没有给予支持或引用你们的贡献,那就有点说不过去了。

希望这项工作能得到丰厚的报酬。

微软可能用RWKV干啥?

RWKV团队猜测,微软可能会将RWKV用于正在测试的本地Copilot、memory recall等功能。

在之前微软发布新一代Copilot+PC中就有提到过,在专为AI重构的新版Windows 11上,许多功能都是实时的。

为此,微软引入了全新的系统架构,将CPU、GPU和新的高性能神经处理单元NPU结合在一起。

NPU就负责在后台实时运行AI,Recall功能背后其实就是AI对你屏幕上正在处理的所有内容做分类。

而RWKV模型的优势是:

支持100多种语言,有利于全球化部署;

相比传统Transformer模型,运行能耗低得多,能够在包括树莓派等各种设备上高效运行。

如下图所示,生成更多token所需的计算资源随token数增加而线性增加,cuda_rwkv-4-pile-3b的曲线在整个过程中相对低了一大截,表明在相同量token情况下,这个模型GPU消耗更为高效。

而能耗对于设备电池寿命而言至关重要。

当然这些只是猜测,关于微软的真实用意,团队表示后续将密切关注。

RWKV是什么?

再来简要介绍一下RWKV,之前量子位也有持续关注,RWKV是魔改RNN挑战Transformer的一种新架构。

RWKV设计灵感来自苹果21年的研究《An Attention Free Transform》,团队意识到如果在公式中使用循环矩阵(circular matrices)就可以将网络结构写成RNN。

与GPT系列的时间复杂度O(n^2)相比,RNN的时间复杂度只有O(n),空间复杂度是O(1)。

这意味着生成内容的速度不会随长度而夸张增涨,显存占用也是恒定的。

论文共同一作彭博在接受36kr采访时曾这样形容:

GPT每写一个字就要重新看一遍前面所有文字,效率很低。而RWKV就相当于人类读了一遍资料后,在不再看资料的情况下直接回答。

这项研究去年一经发布,就在学术圈得到大量关注。

RWKV开山论文背后是由来自27家大学、研究机构和公司的研究人员组成的团队,作者达30人。

共同一作彭博(Peng Bo),毕业于香港大学物理系,编程经验20+年,曾在世界最大外汇对冲基金之一Ortus Capital就职,负责高频量化交易。

还出版过一本关于深度卷积网络的书籍《深度卷积网络·原理与实践》。

他的主要关注和兴趣方向在软硬件开发方面,在此前的公开访谈中,他曾明确表示AIGC是自己的兴趣所在,尤其是小说生成。

但他的最主要公开身份是一家灯具公司禀临科技的联合创始人,主要是做阳光灯、吸顶灯、便携台灯等。

并且其人应该是一个喵星人资深爱好者,Github、知乎、微信头像,以及灯具公司的官网首页、微博上,都有橘猫的身影。

今年,RWKV又上新推出了两种新架构模型:Eagle (RWKV-5) 、Finch(RWKV-6)。

这两种序列模型以RWKV-4架构为基础,在多头矩阵值状态(multi-headed matrix-valued states)和动态递归机制(dynamic recurrence mechanism)上做了改进,提高了RWKV模型的表达能力,同时保持RNN的推理效率特征。

同时,新架构引入了一个新的多语言语料库,包含1.12万亿个token。

团队还基于贪婪匹配(greedy matching)开发了一种快速的分词器,以增强RWKV的多语言性。

文章来源于“量子位”,作者“西风”

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则