基于大模型的Agent会玩宝可梦了,人类水平的那种!

名为PokéLLMon,现在它正在天梯对战中与人类玩家一较高下:

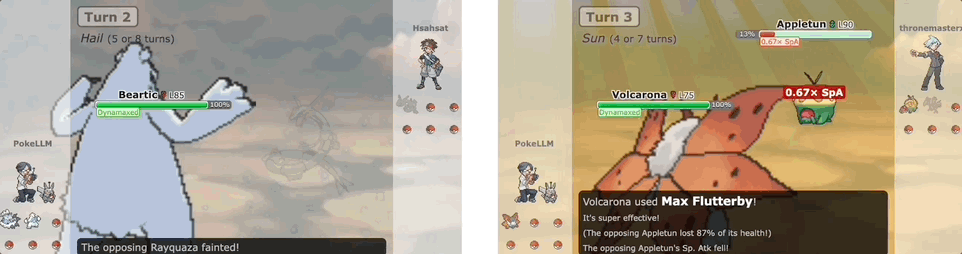

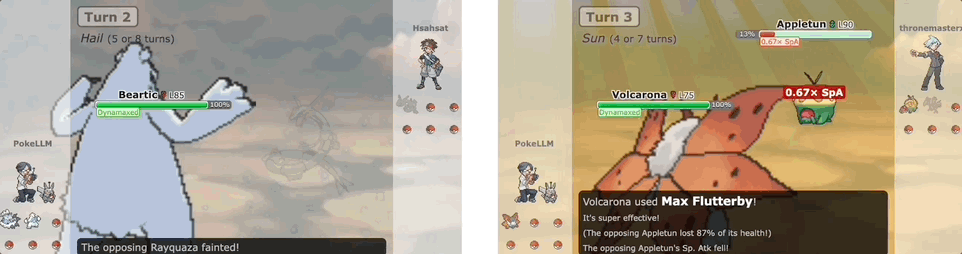

PokéLLMon能灵活调整策略,一旦发现攻击无效,立刻改变行动:

PokéLLMon还会运用人类式的消耗战术,频繁给对方宝可梦下毒,并一边恢复自身HP。

不过面对强敌,PokéLLMon也会“慌乱”逃避战斗,连续切换宝可梦:

最终对战结果是,PokéLLMon在随机天梯赛中取得49%的胜率,与专业玩家的邀请赛中取得56%的胜率,游戏战略和决策水平接近人类。

网友看到PokéLLMon的表现也很意外,直呼:

小心被任天堂封禁,这话是认真的。

甚至有网友喊话宝可梦大满贯选手、世锦赛冠军Wolfey Glick,来和这个AI一较高下:

这究竟是如何做到的?

PokéLLMon大战人类

PokéLLMon由佐治亚理工学院研究团队提出:

具体来说,他们提出了三个关键策略。

一是上下文强化学习(In-Context Reinforcement Learning)。

利用从对战中即时获得的文字反馈作为一种新的“奖励”输入,不需要训练就可以在线迭代完善和调整PokéLLMon的决策生成策略。

其中反馈内容包括:回合HP变化、攻击效果、速度优先级、招式额外效果等。

比如PokéLLMon反复使用相同的攻击招式,但由于对方宝可梦具有“干燥皮肤”的能力,对其没有任何效果。

在第三回合中对战中,通过即时上下文强化学习,PokéLLMon随后选择更换宝可梦。

二是知识增强生成(Knowledge-Augmented Generation)。

通过检索外部知识源作为额外输入,融入到状态描述中。比如检索类型关系、招式数据,模拟人类查询宝可梦图鉴,来减少未知知识导致的“幻觉”问题。

由此一来,PokéLLMon可以准确理解并应用招式效果。

比如面对犀牛进化形态的地面攻击,PokéLLMon未选择更换宝可梦,而是施展“电磁飘浮”,该技能在五回合内成功抵御地面攻击,使犀牛的“地震”技能无效。

三是一致性动作生成(Consistent Action Generation)。

研究人员发现,当PokéLLMon面对强大对手时,思维链(CoT)的推理方式会导致它因“恐慌”而频繁更换道具或宝可梦。

而通过一致性动作生成,可以独立多次生成行动,投票出最一致的,从而缓解“恐慌”。

值得一提的是,研究人员所用的模型自主和人类作战的宝可梦对战环境,基于Pokemon Showdown和poke-env实现,目前已开源。

为了测试PokéLLMon的对战能力,研究人员用它分别与随机天梯赛玩家和一名拥有15年经验的专业玩家对战。

结果,PokéLLMon与天梯随机玩家的胜率为48.57%,与专业玩家的邀请对战胜率为56%。

总的来说,PokéLLMon的优势在于:能准确选择有效招式,统一使用一个宝可梦击倒全部对手;展现出类人的消耗战略,使对手中毒后再拖延回血。

不过研究人员也指出了PokéLLMon的不足之处,面对玩家的消耗战略(拖延回血)很难应对:

容易被玩家的迷惑战术误导(迅速切换宝可梦,巧妙使PokéLLMon浪费强化攻击机会):

团队简介

三位作者均为华人学者。

论文一作胡思昊,现为佐治亚理工学院计算机科学博士生,本科毕业于浙江大学,曾在新加坡国立大学担任研究助理。

研究兴趣包括用于区块链安全和推荐系统的数据挖掘算法及系统。

作者Tiansheng Huang,同为佐治亚理工学院计算机科学博士生,华南理工大学校友。

研究兴趣包括分布式机器学习、并行与分布式计算、优化算法以及机器学习安全性。

导师刘玲,现为佐治亚理工学院计算机系教授。1982年毕业于中国人民大学,1993年于荷兰蒂尔堡大学获博士学位。

刘教授主导分布式数据密集系统实验室(DiSL)的研究工作,专注于大数据系统及其分析的多个方面,如性能、安全和隐私等。

同时她也是IEEE Fellow,2012年获得IEEE计算机学会技术成就奖,还曾担任多个IEEE和ACM大会主席。

参考链接:

[1]https://twitter.com/_akhaliq/status/1754337188014100876

[2]https://poke-llm-on.github.io/

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则