《智能涌现》独家获悉,前百度研究院副院长李平的新创业公司VecML,近期已经完成了产品的探索和初步研发。值得注意的是,VecML近期还邀请到了前雅虎和Ebay首席科学家、前Walmart副总裁,和前微软技术高管Jan Pedersen博士,出任VecML首席战略官(CSO)。

VecML创始人李平博士,于2007年博士毕业于斯坦福大学,获得统计学博士学位,计算机科学硕士学位和电子工程硕士学位。博士毕业后,李平曾在康奈尔大学和罗格斯大学任教,并于2013年成为计算机系和统计系终身教授,并在www.csrankings.org 的全球计算机大学和学者排名中名列前茅。

△李平

李平是完整经历了上一个AI 1.0时代,且在国内大厂完整经历了从0到1搭建AI团队的顶级技术专家。

创业前,李平任微软(LinkedIn)公司的杰出科学家。加入微软之前,李平曾经是百度首席架构师(T11)和百度研究院副院长,并且直接管理百度认知计算实验室(Cognitive Computing Lab,CCL),落地成果包括超大规模深度学习GPU平台、多模态向量检索和生成、强化学习、知识图谱等生成式AI的核心技术。

自ChatGPT推出后不到两年,如今生成式AI浪潮的关注焦点,已经迅速从基座大模型快进到AI应用落地。

尽管生成式AI浪潮的发展速度,已经比历史上任何一个互联网浪潮都更快,但在今年,AI界的共识并不十分牢固——对于“超级应用”的质疑、对OpenAI下一代大模型的疑问和不安,某种程度上,都是AI界和公众热切期待的映射。

同时,这也体现出:生成式AI技术的落地,仍在相当早期的阶段。

在2024年选择成立VecML,就是李平对于AI应用落地难题的冲刺尝试。VecML希望能够做下一代端侧AI的基础架构和边缘计算平台,让端侧的设备,也能完成更高难度的大模型计算。

端侧,即手机、PC、家电等各类终端设备。如今市面上的AI大模型,即使是在手机上展示输出结果,但绝大多数的计算都通过云端进行。

有分析数据显示,目前端侧AI只占整个AI市场5%的份额。原因在于,大模型的体量太大,而PC或手机的芯片,其计算和内存能力又太有限。

这是AI应用落地当下的最大桎梏。

对比普遍在数千亿至万亿参数的大模型,现在的手机端最多也只能运行量化后的70亿(7B)参数内的大模型,也就是说,纯靠端侧的算力,只能承载最简单的应用,如基础的文字对话、生图等等。

如果想让AI应用真正走进大众的生活,现有的端侧“基础设施”——从端侧的电池、芯片等硬件,到软件侧的响应速度等等,达到AI应用能够爆发的阶段,还有很远距离。

从年初成立新公司至今,VecML已经推出了一套端侧AI基础架构和边缘计算平台。

这可以看作是一个部署、开发端侧AI模型的“工具箱”,企业客户通过这个平台,能够完成端侧AI的部署和运行。

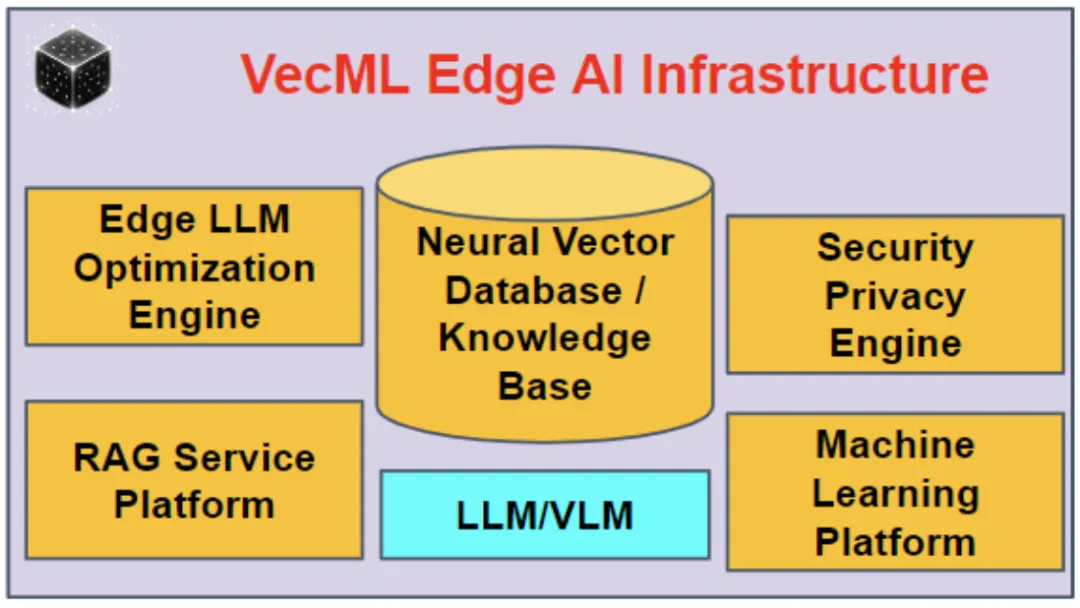

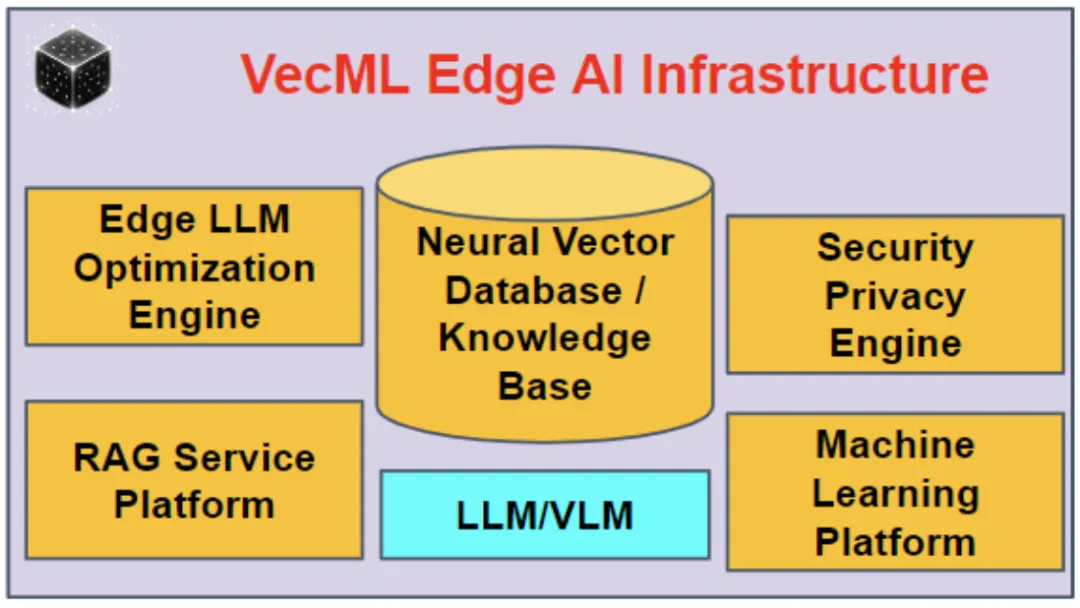

△VecML平台的主要组成部分:端侧大语言模型和优化平台;基于神经网络相似度的向量数据库和知识库;RAG服务平台;安全和隐私保护平台;机器学习平台,包括联邦学习和分布式计算;

李平对《智能涌现》表示,VecML团队均来自微软,百度,亚马逊等IT巨头或者顶尖大语言模型团队,在AI模型安全、隐私计算、大规模分布式计算、联邦学习、模型压缩和数据压缩等领域都有核心原创技术贡献。这是做好端侧AI的必要条件。

在当前专攻的在端侧AI领域,团队也有多年的专业积累。比如,在2017年的NeurIPS上,李平的一项工作即证明了量化压缩的最优平衡点是3-5比特。而现在流行的端侧大模型,即是4比特和3比特模型。

而比起大模型的参数、训练工程之巨大,端侧的核心开发难点,可以说是要怎么在极小的模型和极小的内存空间上精细雕刻。

“比如,手机上的模型只有云端模型百分之一的参数、和千分之一的上下文长度(即每次和模型交互,单次输入的文本长度)。如果要做好RAG功能,在云端大模型上,如果不计成本,只要直接扔文件进去就好,但在手机上大模型需要在文件中,精准找到直接相关的文件部分,加起来不能超过数百token,再放进提示词中。”李平对《智能涌现》解释。

△基于VecML开发的,可以运行在Android手机上的APP,不需联网

当前,基于VecML开发的手机端大模型应用,已上线了包括本地视频/图像搜索、智能本地文件搜索等等功能,调用速度也显著快于基于云端的大模型。

如果AI可以全部或部分在端侧完成,这意味着什么?

首先,企业在云计算上的开销就基本没有了,对企业成本和社会成本的节省将有巨大意义。

另外,因为用户数据的存储和计算都在本地,AI大模型涉及的隐私问题会得以有效解决——就在前不久,苹果AI的隐私隐患就被马斯克猛烈抨击。而在8月,荷兰数据保护局(DPA)在其官网宣布对优步(Uber),因为其把欧洲用户隐私数据传回美国,处以2.9亿欧元的罚款。

这也会很有效地提升算力利用效率。分布式计算天然和端侧AI紧密相关。数量巨大的端侧设备可以联合起来一起训练或者推理,真正把端侧算力充分利用起来。有效的分布式计算需要解决非常多的技术难题,包括隐私保护,数据压缩,高效数据传输,高效优化算法等。

VecML所在的AI Infra赛道,是链接算力和应用的中间层基础设施。在基座模型仍在快速迭代时,其“承上启下”的地位更加重要——如何充分挖掘现有模型的潜力,决定着AI应用能够走多远、多深。对模型前沿技术的突破,就至关重要。

谈及VecML的优势,李平表示,当前公司已积累的多项原创技术,可让端侧AI的计算效率大大提升。

比如,手机上存储的数据很多都为非结构化数据,需要通过建立向量关系,来让AI可以准确搜索到这些数据。目前,业界在手机上使用的向量数通常不超过20万,但通过VecML的原创方案,可以在降低内存10倍的前提下,也不影响AI搜索速度,这意味着手机上可以建立上千万向量的数据库。

另外,在隐私保护层面,两种主流技术路线包括多方计算和差分隐私,但都有其局限。其基于加密解密的多方计算速度太慢,远不能满足实用需求;而基于差分隐私算法因为对精度损失太大极少被工业界采用。

当前,VecML的原创隐私保护技术,已经可以在基本上不影响精度的前提下,达到数学上严格的隐私保护要求。

近期加入VecML的Jan Pedersen博士,是一位AI界老兵。他在1998年就在搜索先驱公司InfoSeek任总监,和如今的百度CEO李彦宏曾经是同事。Jan Pedersen曾于AltaVista、雅虎和亚马逊担任过首席科学家职位,而后加入微软。2016年,他被任命为微软集团的Technical Fellow,当年这是在全球仅有20位的高管。

△Jan Pedersen博士

据Bessemer 2024年的AI Infra报告,生成式AI浪潮来临后,数据数量,尤其是非结构化数据,到2030年预计将激增至612 ZB,这将逼近现有基础设施的极限,也在倒逼其进行更新。

因此,从2023年开始,AI Infra的创业热度大大提升,从AI训练、框架、观测、部署、评估等等环节,都有不少公司入局,开发相应的基础设施平台产品。

这个赛道接下来或许要迎来一场加速战。如今,全球手机、PC厂商都把AI作为发展重点,端侧AI是他们不能允许自己错过的下一代入口。而就在这个9月,苹果正式发布第一台AI手机iPhone 16,也又一次把大众对端侧AI(Edge AI)的关注,推向新高峰。

封面来源|视觉中国

文章来源“智能涌现”,作者“邓咏仪”

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则