摘要:人工智能的历史,特别是深度学习,具有重要的里程碑意义,始于1956年达特茅斯会议上人工智能的概念化。早期的突破,如麦卡洛克-皮茨神经元模型和感知器,为理解神经计算奠定了基础。ADALINE的引入和对XOR问题复杂性的认识突出了对更复杂模型的需求,导致了多层感知器(MLP)的发展。20世纪80年代引入的反向传播算法和通用近似定理为神经网络的功能提供了理论基础。卷积神经网络(CNN)彻底改变了图像处理和计算机视觉,而递归神经网络(RNN)在顺序数据任务中表现出色。Transformers具有自我注意机制,已经成为自然语言处理的核心,例如BERT和GPT-3等模型。该领域已经发展到多模态模型,如GPT-4V和GPT-4-o,它们集成了文本、图像和其他模态。扩散模型已经成为一类强大的生成模型,为高保真样本生成提供了新的方法。最新的发展包括用于AI图像生成的高级扩散模型,如FLUX.1,以及新的文本到视频生成模型,如OpenAI索拉,反映了AI正在进行的创新。

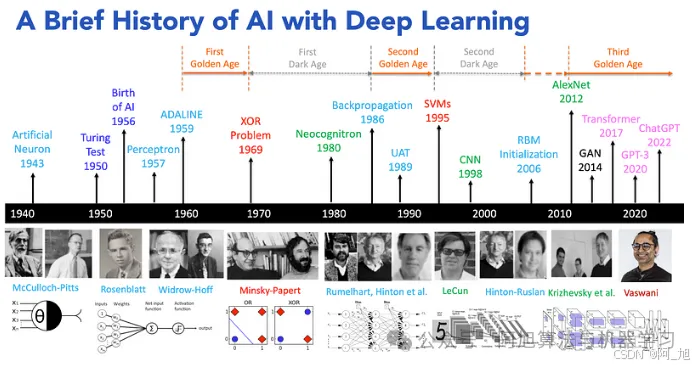

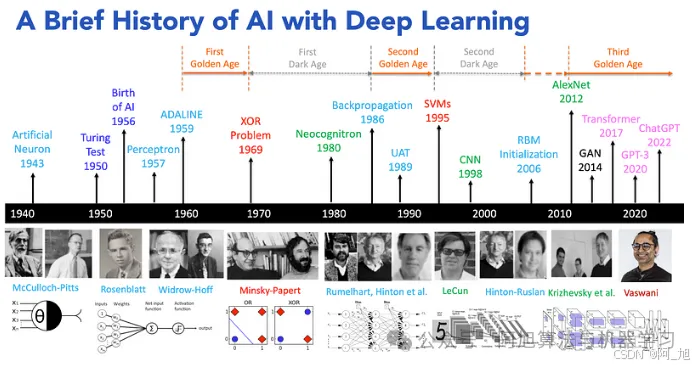

AI与深度学习的简史

人工智能(AI)和深度学习在过去几十年中取得了显着进展,改变了计算机视觉,自然语言处理和机器人等领域。本文概述了使用深度学习的AI历史上的关键里程碑,从早期的神经网络模型到现代的大型语言模型和多模态AI系统。

在这里插入图片描述

1.人工智能的诞生(1956)

人工智能(AI)的概念已经存在了几个世纪,但我们今天所知的现代AI领域在世纪中期开始形成。“人工智能”一词最早由计算机科学家和认知科学家约翰·麦卡锡于1956年在达特茅斯人工智能夏季研究项目中提出。

达特茅斯会议通常被认为是人工智能作为一个研究领域的诞生地。这次会议聚集了一群计算机科学家、数学家和认知科学家,讨论创造能够模拟人类智能的机器的可能性。与会者包括著名人物,如马文明斯基,纳撒尼尔罗切斯特和克劳德香农。

在这里插入图片描述

1.1人工智能的进化:从基于规则的系统到深度学习

人工智能的发展始于20世纪50年代,当时开发了国际象棋和解决问题等任务的算法,第一个人工智能程序Logical Theorist于1956年创建。1960年代和1970年代采用了基于规则的专家系统,如MYCIN,可以协助复杂的决策过程。20世纪80年代出现了机器学习,它使人工智能系统能够从数据中学习并随着时间的推移而改进,为现代深度学习技术奠定了基础。

如今,大多数尖端人工智能技术都是由深度学习技术驱动的,这些技术已经改变了人工智能的格局。深度学习是机器学习的一个专门分支,它利用多层人工神经网络从原始输入数据中提取复杂特征。在本文中,我们将探索人工智能的历史,强调深度学习在其发展中的作用。

2.早期人工神经网络(1940 – 1960年代)

2.1 03 The Lost of the Lost(1943)

神经网络的概念可以追溯到1943年,当时Warren McCulloch和Walter Pitts提出了第一个人工神经元模型。McCulloch-Pitts(MP)神经元模型是对生物神经元的突破性简化。该模型为人工神经网络奠定了基础,通过聚合二进制输入,并基于此聚合使用阈值激活函数进行决策,从而产生二进制输出{0,1}。

在这里插入图片描述

这个简化的模型抓住了神经元行为的本质–接收多个输入,将它们积分,并根据积分信号是否超过阈值产生二进制输出。尽管它很简单,但MP神经元模型能够实现基本的逻辑运算,展示了神经计算的潜力。

2.2 Rosenblatt的感知器模型(1957)

1957年,Frank Rosenblatt提出了Perceptron,一种能够学习和识别模式的单层神经网络。感知器模型是一个比MP神经元更通用的计算模型,旨在处理实值输入并调整权重以最大限度地减少分类错误。

在这里插入图片描述

Rosenblatt还为Perceptron开发了一种监督学习算法,该算法允许网络直接从训练数据中学习。

在这里插入图片描述

Rosenblatt雄心勃勃地宣称感知器的能力,包括识别个人和在语言之间翻译语音的潜力,在此期间引起了公众对人工智能的极大兴趣。感知器模型及其相关的学习算法标志着神经网络发展的重要里程碑。然而,一个关键的限制很快变得明显:感知器的学习规则在非线性可分离的训练数据中无法收敛。

2.3 ADALINE(1959)

1959年,Widrow和霍夫引入了ADALINE(自适应线性神经元,又称Delta学习规则),这是对感知器学习规则的改进。ADALINE解决了二进制输出和噪声敏感性等限制,可以学习和收敛非线性可分离数据,这是神经网络开发的重大突破。

在这里插入图片描述

ADALINE的主要功能包括:

- 线性激活函数:与Perceptron的阶跃函数不同,ADALINE使用线性激活函数,使其适用于回归任务和连续输出。

- 最小均方(LMS)算法:ADALINE采用LMS算法,最大限度地减少预测和实际输出之间的均方误差,提供更有效和更稳定的学习过程。

- 自适应权重:LMS算法根据输出误差自适应调整权重,使ADALINE即使在存在噪声的情况下也能有效学习和收敛。

ADALINE的引入标志着神经网络第一个黄金时代的开始,克服了Rosenblatt感知器学习的局限性。这一突破实现了高效学习、持续输出和对噪声数据的适应,引发了该领域的创新浪潮和快速进步。

在这里插入图片描述

然而,像感知器一样,ADALINE仍然局限于线性可分离的问题,无法解决更复杂和非线性的任务。这个限制后来被XOR问题突出,导致更先进的神经网络架构的发展。

2.4异或问题(1969)

1969年,Marvin Minsky和Seymour Papert在他们的书《Perceptrons》中强调了单层感知器的严重局限性。他们证明,由于其线性决策边界,感知器无法解决异或(XOR)问题,这是一个简单的二元分类任务。XOR问题不是线性可分的,这意味着没有一个线性边界可以正确地分类所有输入模式。

在这里插入图片描述

这一发现强调了对能够学习非线性决策边界的更复杂神经网络架构的需求。感知器局限性的暴露导致人们对神经网络失去信心,并转向符号AI方法,标志着从20世纪70年代初到80年代中期的“神经网络的第一个黑暗时代”的开始。

神经网络的第一个黑暗时代

然而,从解决XOR问题中获得的见解使研究人员认识到需要更复杂的模型来捕捉非线性关系。这一认识最终导致了多层感知器和其他先进神经网络模型的发展,为后来几十年神经网络和深度学习的复兴奠定了基础。

3.多层感知器(MLP)(1960年代)

多层感知器(MLP)是在20世纪60年代引入的,作为对单层感知器的改进。它由多层相互连接的神经元组成,使其能够解决单层模型的局限性。苏联科学家A. G. Ivakhnenko和V. Lapa在Perceptron的基础工作上为MLP的发展做出了重大贡献。

在这里插入图片描述

3.1隐藏层

隐藏层的添加允许MLP捕获和表示数据中复杂的非线性关系。这些隐藏层显著增强了网络的学习能力,使其能够解决不可线性分离的问题,例如XOR问题。

在这里插入图片描述

3.2 MLP的历史背景和挑战

MLP标志着神经网络研究的重大进步,展示了深度学习架构解决复杂问题的潜力。然而,在1960年代和1970年代,若干挑战阻碍了示范法的发展:

- 缺乏训练算法:早期的MLP模型缺乏可以有效调整网络权重的有效训练算法。由于缺乏反向传播,很难训练具有多层的深度网络。

- 计算限制:当时可用的计算能力不足以处理训练深度神经网络所需的复杂计算。这种限制减缓了MLP研究和开发的进展。

神经网络的第一个黑暗时代结束于1986年,反向传播算法的重新发现和出版,开启了神经网络的第二个黄金时代。

神经网络的第二个黄金时代

4.反向传播(1970 – 1980年代)

1969年,XOR问题凸显了感知器(单层神经网络)的局限性。研究人员意识到,多层神经网络可以克服这些限制,但他们缺乏一种实用的算法来训练这些复杂的网络。反向传播算法花了17年的时间才被开发出来,使神经网络能够在理论上逼近任何函数。有趣的是,后来发现该算法实际上是在其出版之前发明的。

如今,反向传播是深度学习的基本组成部分,自20世纪60年代和70年代问世以来,已经经历了重大的进步和改进。

4.1早期发展(1970年代)

- Seppo Linnainmaa(1970):引入了自动微分的概念,这是反向传播算法的关键组成部分。

- Paul Werbos(1974):提出使用微积分的链式法则来计算误差函数相对于网络权重的梯度,从而实现多层神经网络的训练。

4.2改良与普及(1980年代)

- 大卫鲁梅尔哈特,杰弗里欣顿和罗纳德威廉姆斯(1986):提出反向传播作为一种实用和有效的方法来训练深度神经网络,展示了它在各种问题中的应用。

在这里插入图片描述

4.3 反向传播的主要特点

- 梯度下降:反向传播与梯度下降结合使用,以最小化误差函数。该算法计算误差相对于网络中每个权重的梯度,允许迭代更新权重以减少误差。

- 链式法则:反向传播算法的核心是微积分链式法则的应用。该规则允许将误差的梯度分解为一系列偏导数,这些偏导数可以通过网络的反向传递来有效地计算。

- 分层计算:反向传播以逐层的方式操作,从输出层开始,向后工作到输入层。这种分层计算确保梯度通过网络正确传播,从而能够训练深度架构。

4.5 通用逼近定理(1989)

1989年乔治·西本科提出的通用近似定理为多层神经网络的能力提供了数学基础。该定理指出,具有单个隐藏层的前馈神经网络可以近似任何连续函数到任意精度,给定足够的神经元并使用非线性激活函数。这一定理强调了神经网络的能力和灵活性,使其适用于广泛的应用。

具有单个隐藏层的多层神经网络可以将任何连续函数近似到任何所需的精度,从而能够解决各个领域的复杂问题。

4.6第二个黄金时代(1980年代末至1990年代初)

反向传播和通用逼近定理(UAT)的发展标志着神经网络第二个黄金时代的开始。反向传播为训练多层神经网络提供了一种有效的方法,使研究人员能够训练更深入,更复杂的模型。UAT为多层神经网络的使用提供了理论依据,并增强了人们对它们解决复杂问题能力的信心。这一时期,跨越1980年代末和1990年代初,看到了兴趣的复苏和该领域的重大进展。

在这里插入图片描述

4.7第二次黑暗时代(1990年代初至2000年代初)

然而,由于以下几个因素,神经网络领域在20世纪90年代初到21世纪初经历了“第二个黑暗时代”:

- 支持向量机(SVM)的兴起,为分类和回归任务提供了一种数学上优雅的方法。

- 计算限制,因为训练深度神经网络仍然是耗时和硬件密集型的。

- 过度拟合和泛化问题,早期的神经网络在训练数据上表现良好,但在看不见的数据上表现不佳,这使得它们在实际应用中不太可靠。

这些挑战导致许多研究人员将注意力从神经网络转移,导致该领域出现了一段停滞期。

4.8深度学习的复兴(21世纪末至今)

神经网络领域在2000年代末和2010年代初经历了一次复兴,这是由以下方面的进步推动的:

- 深度学习架构(CNN、RNN、Transformers、Diffusion Models)

- 硬件(GPU、TPU、LPU)

- 大规模数据集(ImageNet、COCO、OpenWebText、WikiText等)

- 训练算法(SGD、Adam、dropout)

这些进步导致了计算机视觉、自然语言处理、语音识别和强化学习方面的重大突破。普适近似定理与实践进步相结合,为深度学习技术的广泛采用和成功铺平了道路。

5.卷积神经网络(1980 – 2010)

卷积神经网络(CNN)极大地改变了深度学习的格局,特别是在计算机视觉和图像处理领域。它们从20世纪80年代到2010年代的演变反映了架构,培训技术和应用的重大进步。

在这里插入图片描述

5.1早期发展(1989-1998)

CNN的概念最早是在20世纪80年代由Kenji福岛提出的,他提出了Neocognitron,一种模仿人类视觉皮层结构的分层神经网络。这项开创性的工作为CNN的发展奠定了基础。在20世纪80年代末和90年代初,Yann LeCun和他的团队进一步开发了CNN,引入了专门为手写数字识别设计的LeNet-5架构。

在这里插入图片描述

5.2 CNN的关键组件

CNN由三个关键组件构成:

- 卷积层:这些层通过应用一组可学习的过滤器自动从输入图像中学习特征的空间层次。

- 池化层:池化层减少了输入的空间维度,增强了对变化的鲁棒性并降低了计算负载。

- 全连接层:在卷积层和池化层之后,全连接层用于分类任务,集成从先前层学习的特征。

5.3 CNN的主要特点

- 局部感受野:CNN使用局部感受野来捕获输入数据中的局部模式,使其对图像和视觉任务非常有效。

- 共享权重:在卷积层中使用共享权重减少了网络中的参数数量,使其更有效,更容易训练。

- 平移不变性:池化层引入平移不变性,允许网络识别模式,而不管它们在输入图像中的位置。

5.4 CNN的崛起:AlexNet的影响(2012)

2012年,CNN的发展达到了一个重要的里程碑,AlexNet在ImageNet大规模视觉识别挑战赛(ILSVRC)中获胜,取得了巨大的胜利,标志着图像分类的重大突破。

AlexNet的架构(2012)

ILSVRC是一个年度图像识别基准测试,它评估了超过1000万张带注释图像的数据集上的算法,这些图像分为1000个类别。AlexNet的创新包括:

- ReLU激活函数:为了克服传统激活函数的问题,ReLU实现了更快的训练和更高的性能。

- 丢弃正则化:这种技术通过在训练过程中随机丢弃单元来减少过拟合。

- 数据增强:对训练数据集的增强通过人为增加训练数据的多样性来提高泛化能力。

AlexNet的成功标志着CNN发展的转折点,为图像分类和目标检测的进一步发展铺平了道路。

在这里插入图片描述

AlexNet开启神经网络的第三个黄金时代

当前的黄金时代(21世纪10年代至今)以深度学习、大数据和强大计算平台的融合为标志。这个时代在图像识别、自然语言处理和机器人技术方面取得了显著的突破。正在进行的研究继续推动AI能力的边界。

AlexNet开启了神经网络的第三个黄金时代

5.5后续架构

继AlexNet之后,出现了几个有影响力的架构:

- VGGNet(2014):由牛津大学的Visual Geometry Group开发,VGGNet强调更深层次的架构,使用更小的卷积滤波器(3x 3),实现了卓越的准确性。

- GoogLeNet/Inception(2014):引入了初始模块,允许网络有效地捕获多尺度特征。

- ResNet(2015):残差网络引入了跳过连接,使非常深的网络的训练,同时减轻消失梯度问题。

在这里插入图片描述

5.6 CNN的应用

CNN的进步已经彻底改变了各个领域:

- 计算机视觉:CNN已成为现代计算机视觉的支柱,使图像分类,对象检测和语义分割取得突破。

- 医学成像:CNN用于疾病诊断、肿瘤检测和图像引导手术等任务,显著提高了诊断准确性。

- 自动驾驶汽车:CNN是自动驾驶汽车感知系统不可或缺的一部分,允许它们解释和响应周围环境。

在这里插入图片描述

CNN从一开始到目前作为深度学习基石的历程说明了它们对人工智能的深远影响。CNN的成功也为深度学习的进一步发展铺平了道路,并激发了其他专业神经网络架构的发展,如RNN和Transformer。CNN的理论基础和实践创新为深度学习技术在各个领域的广泛采用和成功做出了重大贡献。

6.递归神经网络(1986-2017)

递归神经网络(RNN)是处理时序数据的强大架构。与前馈神经网络不同,RNN被设计用于处理输入序列,使其对语言建模,时间序列预测和语音识别等任务特别有效。

6.1早期发展(1980年代-1990年代)

RNN的概念可以追溯到20世纪80年代,其中包括John Hopfield、Michael I. Jordan和Jeffrey L. Elman为这些网络的发展做出了贡献。由John Hopfield在1982年提出的Hopfield网络为理解神经网络中的递归连接奠定了基础。Jordan网络和Elman网络分别在20世纪80年代和90年代提出,是捕获序列数据中时间依赖性的早期尝试。

在这里插入图片描述

6.2 LSTM、GRU和Seq 2Seq模型(1997 – 2014)

- 长短期记忆(LSTM)网络(1997):Sepp Hochreiter和Jürgen Schmidhuber介绍了长短期记忆(LSTM)网络,它解决了传统RNN中的消失梯度问题。LSTM使用门控机制来控制信息流,允许它们捕获序列数据中的长期依赖关系。

- Gated Recurrent Units(GRUs)(2014):Kyunghyun Cho等人提出了Gated Recurrent Units(GRUs),这是LSTM的简化版本,也使用门控机制来控制信息流。GRU比LSTM具有更少的参数,并且通常训练得更快。

在这里插入图片描述

- 序列到序列模型(Seq 2Seq)****(2014):Ilya Sutskever和他的团队引入了Seq 2Seq模型,该模型使用编码器-解码器架构将输入序列映射到输出序列。该模型已广泛用于机器翻译、语音识别和文本摘要等任务。

在这里插入图片描述

6.3 RNN递归连接的关键特征

RNN使用循环连接来维护隐藏状态,以捕获来自先前时间步的信息。这允许网络对顺序数据中的时间依赖性进行建模。

- 通过时间反向传播(BPTT):RNN使用称为通过时间反向传播(BPTT)的反向传播变体进行训练,该变体随时间展开递归网络,并将标准反向传播算法应用于展开的网络。

- 门控机制:高级RNN架构,如LSTM和GRU,使用门控机制来控制信息流,有助于缓解消失梯度问题,并使网络能够捕获长期依赖关系。

6.4 RNN应用

RNN对各个领域产生了重大影响,包括:

- 自然语言处理:RNN彻底改变了自然语言处理领域,使语言建模、机器翻译、情感分析和文本生成等任务取得了重大进展。

- 语音识别:RNN广泛用于语音识别系统,它们对口语中的时间依赖性进行建模,将语音信号转换为文本。

- 时间序列预测:RNN对于时间序列预测是有效的,它们对序列数据中的时间依赖性进行建模,以预测未来的值。

在这里插入图片描述

6.5 RNN的挑战

尽管RNN取得了成功,但它面临着一些挑战:

- 消失和爆炸性事件:传统的RNN正在努力解决这些问题,尽管LSTM和GRU提供了一些解决方案。

- 计算复杂性:训练RNN可能是资源密集型的,特别是对于大型数据集。

- 并行化:RNN的顺序性质使并行训练和推理过程变得复杂。

RNN的成功为深度学习的进一步发展铺平了道路,并激发了其他专业神经网络架构的发展,例如Transformers,它们在各种顺序数据任务中实现了最先进的性能。RNN的理论基础和实践创新为深度学习技术在各个领域的广泛采用和成功做出了重大贡献。

7.Transformers(2017年至今)

Transformers凭借其处理序列数据的上级能力改变了深度学习的格局,成为从自然语言处理(NLP)到计算机视觉等许多领域的关键。

7.1Transformers介绍(2017)

Transformer模型是由Vaswani等人提出的。(2017)在开创性的论文“注意力是你所需要的一切。“这种模型放弃了传统的RNN顺序处理,采用了自注意机制,允许并行处理和更好地处理远程依赖关系。

在这里插入图片描述

7.2Transformers的主要特点

- 自注意机制:允许序列中的每个位置都注意到所有位置,比RNN或LSTM更灵活地捕获上下文。

- 并行化:通过同时处理所有输入数据来提高训练速度,这与RNN的顺序性质形成鲜明对比。

- 编码器-解码器结构:编码器和解码器堆栈都利用自注意和前馈神经网络层,并使用位置编码来维持序列顺序。

在这里插入图片描述

在这里插入图片描述

7.3基于transformer的语言模型(2017年至今)

- BERT(2018):来自Transformers的双向编码器表示,一个仅编码器的Transformer,通过对掩码语言建模和下一句预测的预训练彻底改变了NLP。

- T5(2019):文本到文本传输Transformer,一个编码器-解码器Transformer,将NLP任务重新构建为文本到文本格式,简化了模型架构和训练。

在这里插入图片描述

OpenAI的GPT系列:

- GPT(2018):Generative Pre-trained Transformer,一种自回归解码器专用的Transformer,由OpenAI推出,专注于预测文本序列中的下一个单词,展示了令人印象深刻的语言理解和生成能力。

- GPT-2(2019):比其前身大得多,它显示了零射击任务性能等紧急功能,引发了关于人工智能潜在滥用的讨论,因为它能够生成连贯的,但有时会误导的文本。

- GPT-3(2020):拥有1750亿个参数,GPT-3进一步扩展了语言模型的可能范围,在最小微调的任务中表现出色,称为少量学习。作为仅限解码器的Transformer,GPT-3的自回归架构使其能够根据序列中之前的单词一次生成一个单词的文本。

- ChatGPT(2022):GPT-3.5系列模型的微调版本,针对对话参与进行了优化,展示了指令调优的力量,使模型响应与用户意图保持一致。

在这里插入图片描述

7.4大型语言模型(LLMs)

大型语言模型(LLMs)的前景已经被各种突出的模型大大丰富,每个模型都提供了独特的功能和人工智能的进步。以下是一些知名LLMs的最新概述:

- Anthropic的Claude(2022):优先考虑人工智能输出中的安全和道德因素,旨在与人类价值观保持一致。

- Meta’s LLaMA(2023):提供不同大小的模型,满足不同的计算需求,在自然语言处理基准测试中取得了令人印象深刻的结果。

- Mistral.AI的Mistral(2023):平衡高性能和资源效率,非常适合实时应用,专注于开源AI解决方案。

- 阿里巴巴的Qwen(2023):为英语和中文创建高质量的双语AI模型,促进跨语言应用并鼓励创新。

- 微软的Phi(2023):强调跨各种应用程序的通用性和集成,以及用于上下文理解和用户交互的高级培训技术。

- Google的Gemma系列(2024):轻量级、最先进的开放模型,适用于各种应用程序,包括文本生成、摘要和提取,重点关注性能和效率。

在这里插入图片描述

在这里插入图片描述

8.多模态模型(2023年至今)

8.1 GPT-4V(2023)和GPT-4-o(2024)

- GPT-4V(2023)通过将多模态功能集成到已经强大的基于文本的模型中,标志着人工智能发展的重要一步。它不仅可以处理和生成文本内容,还可以处理和生成图像内容,为更全面的人工智能交互奠定了基础。

在这里插入图片描述

- GPT-4-o(2024)是GPT-4V的演变,带来了增强的多模态集成和复杂的上下文理解。它通过提供跨不同媒体的更好的一致性,从文本提示生成高级图像以及基于视觉输入的精细推理来改进其前身。此外,GPT-4-o还包括先进的道德协调培训机制,确保其产出不仅准确,而且负责任,符合人类价值观。

8.2谷歌的Gemini(2023年至今)

- Gemini Pro(2023):Google的Gemini推出了一系列专为多模式任务设计的模型,集成了文本,图像,音频和视频处理。特别是Gemini Pro,其可扩展性和效率突出,使高级AI可用于各种应用程序,从实时分析到跨不同媒体格式的复杂内容生成。

- Gemini的多模式功能:Gemini模型,包括用于不同规模应用的Ultra和Nano版本,旨在执行需要理解多种数据类型的任务。他们在视频摘要、多模式翻译和交互式学习环境等任务中表现出色,这表明谷歌致力于推进人工智能在多媒体环境中的作用。

8.3Claude 3.0 和Claude 3.5(2023年至今)

- Claude 3.0(2023)由Anthropic推出,该模型专注于提高人工智能响应的安全性和可靠性,并改进了上下文理解和道德考虑。它的目的是更对话和有益的,同时保持严格遵守,以避免有害或有偏见的输出。

- Claude 3.5(2024)进一步完善了Claude 3.0的功能,在复杂任务中提供更好的性能,提高了处理效率,甚至更细致地处理用户请求。该版本还强调多模式交互,尽管它主要擅长文本和逻辑任务,但在处理视觉或其他感官输入方面具有新兴功能,以获得更集成的用户体验。

8.4 LLaVA(2023)

- LLaVA(Large Language and Vision Assistant)代表了多模态AI的创新方法,将语言理解与视觉处理相结合。LLaVA开发于2023年,可以解释图像并将其与文本内容联系起来,使其能够回答有关图像的问题,描述视觉内容,甚至基于视觉线索生成文本。它的架构利用了Transformer模型的优势,在需要视觉和语言理解的任务中实现最先进的性能。该模型以其开源性质而闻名,鼓励多模式AI应用的进一步研究和开发。

在这里插入图片描述

8.5 OpenAI索拉(2024)

OpenAI索拉是一种新的文本到视频生成模型,它扩展了OpenAI多模式AI产品的功能。该模型允许用户从文本描述创建视频,有效地弥合了文本和动态视觉内容之间的差距。索拉集成到多模式框架中增强了创造性应用的潜力,使用户能够以最少的输入生成丰富的多媒体内容。这一发展标志着向更直观和交互式的AI系统迈出了重要一步,这些系统可以理解和生成复杂形式的媒体。

这些模型共同标志着AI系统的转变,不仅可以理解和生成文本,还可以跨各种模式解释和创建内容,更紧密地反映人类的认知能力。人工智能模型的这种演变促进了更具交互性,直观性的应用程序,并且能够通过混合不同的感官输入来处理现实世界的场景,从而扩大了人工智能在日常生活,研究和行业应用中所能实现的范围。

9.扩散模型(2015年至今)

扩散模型已经上升为一个有影响力的类别生成模型,提供了一个新的方法来创建高保真的样本从复杂的数据分布。他们的方法与GAN和VAE等传统模型形成对比,采用了渐进式去噪技术,该技术在许多应用中表现出色。

9.1扩散模型介绍(2015)

Sohl-Dickstein et al.(2015)在他们的论文中介绍了扩散模型。他们概念化了一个生成过程,在这个过程中,逆转逐渐增加的噪声可以将噪声转换回结构化数据。

在这里插入图片描述

9.2扩散模型的主要特征

- 去噪过程:这些模型逐步添加噪声(前向过程),并学习反向(后向过程),有效地去噪以产生样本。

- 马尔可夫链:这两个过程都被构造为马尔可夫链,每个向前的步骤都会添加高斯噪声,模型会学习如何反向去除高斯噪声。

- 训练目标:目标是最小化每一步预测和实际噪声之间的差异,优化证据下限(ELBO)的形式。

- 稳定性和鲁棒性:它们提供比GAN更好的稳定性,避免了模式崩溃等问题,从而始终如一地生成多样化的高质量输出。

在这里插入图片描述

9.3扩散模型的进展(2020年至今)

- 去噪扩散概率模型(DDPM)(2020):细化扩散过程,为图像合成设定新的基准。

- 去噪扩散隐式模型(DDIM)(2021):通过非马尔可夫采样提高效率,使生成过程更加灵活。

- 基于分数的生成模型通过随机微分方程(2021):利用随机微分方程进行有效的样本生成。

- 潜在扩散模型(2022):成为流行的文本到图像生成系统(如稳定扩散)的基础,大大推进了人工智能生成图像的领域,并为更容易访问和更有效的生成人工智能工具铺平了道路。

在这里插入图片描述

9.3应用

- 文本到图像生成:DALL-E 3和Stable Diffusion 3等模型擅长从文本描述生成高质量图像,DALL-E 3提供详细准确的视觉效果,Stable Diffusion提供开源替代方案,使图像生成技术民主化。

在这里插入图片描述

- FLUX.1(2024):黑森林实验室推出了FLUX.1,这是一种用于AI图像生成的高级扩散模型,可提供卓越的速度,质量和及时的依从性。有三个版本- Schnell,Dev和Pro – FLUX.1利用整流流量变压器等创新技术来产生高度逼真的图像。FLUX.1可以生成文本并处理手指和脚趾等细节-这是一个好的图像生成器所需要的一切。

在这里插入图片描述

- DreamBooth(2022):在特定主题的一些图像上启用训练扩散模型,允许个性化图像生成。

- LoRA(2022):代表低秩自适应,一种允许用最少的附加参数微调扩散模型的技术,使模型更容易适应特定的任务或数据集。

在这里插入图片描述

- ControlNet(2023):根据草图或深度图等额外输入来调节扩散模型,从而对生成的图像提供更多控制。

在这里插入图片描述

- Multi-SBoRA(2024):Multi-SBoRA是一种为多个概念定制扩散模型的新方法。它使用正交标准基向量来构造用于微调的低秩矩阵,允许区域和非重叠的权重更新,以减少跨概念干扰。这种方法保留了预训练模型的知识,减少了计算开销,并增强了模型的灵活性。实验结果表明,Multi-SBoRA在多概念定制中实现了最佳性能,同时保持了独立性并减轻了串扰影响。

在这里插入图片描述

扩散模型研究的轨迹表明了一个充满希望的未来,具有集成模型的潜力,这些模型结合了各种AI架构的联合收割机优势,同时优化了速度和质量。

10.结论

人工智能和深度学习的历史以重大进步和变革性创新为标志。从早期的神经网络到复杂的架构,如卷积神经网络(CNN)、循环神经网络(RNN)、Transformer和扩散模型,该领域已经彻底改变了各个领域。

最近的进步导致了大型语言模型(LLMs)和大型多模态模型(LLM)的发展,例如OpenAI的GPT-4 o,Google的Gemini Pro,Antropic的Claude 3.5 Sonnet和Meta的LLaMA 3.1,它们展示了令人印象深刻的自然语言和多模态功能。此外,生成式人工智能的突破,包括文本到图像和文本到视频生成模型,如Midjourney,DALL-E 3,Stable Diffusion,FLUX.1和索拉,扩大了人工智能的创造潜力。

扩散模型也已成为具有不同应用的强大生成模型。随着研究继续专注于开发更高效、更可解释和更有能力的模型,人工智能和深度学习对社会和技术的影响只会越来越大。这些进步正在推动传统领域的创新,并为创造性表达、解决问题和人类与人工智能协作创造新的可能性。

文章来自于微信公众号“阿旭算法与机器学习”,作者“阿旭”

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则