自推出了使用一整个晶圆制造的芯片以来,Cerebras在过去几年里的宣传,都是以攻进英伟达所把持的AI芯片市场为目标。

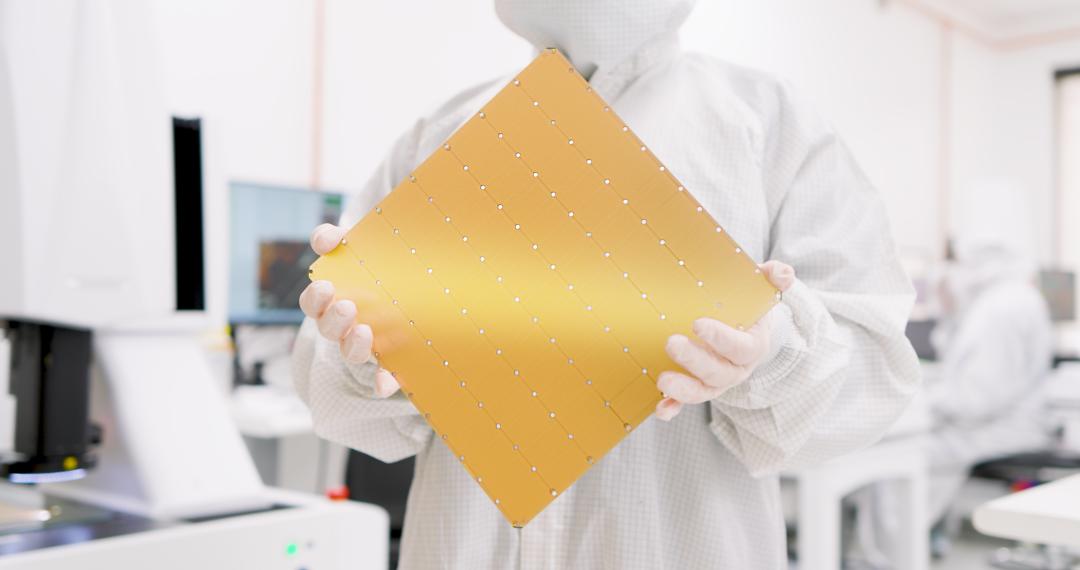

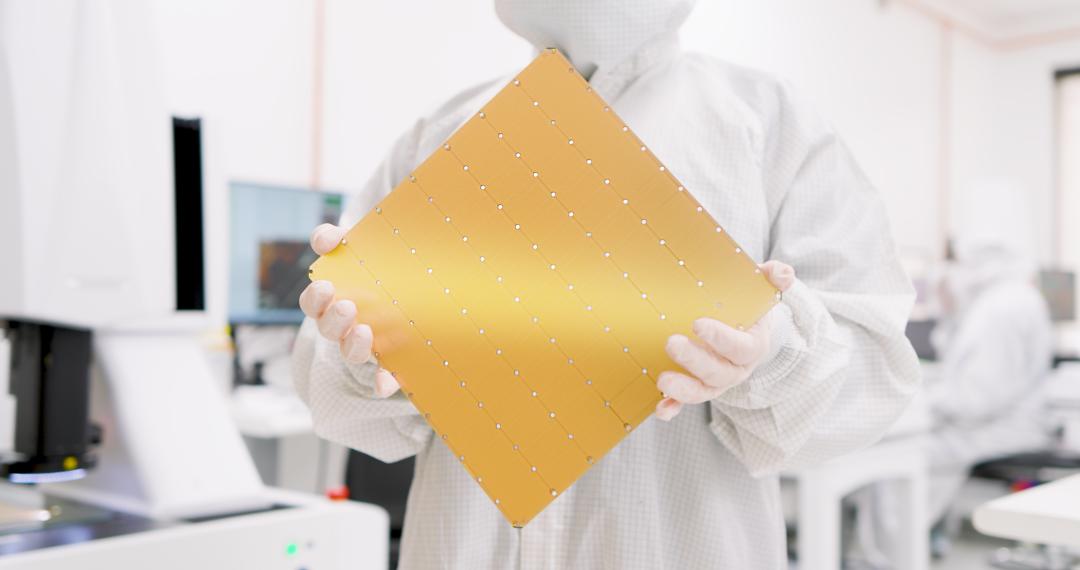

在今年年初,Cerebras Systems推出了专为训练 AI 生态系统最大的 AI 模型而设计的 WSE-3 AI 芯片。据介绍,这颗基于 5nm、4 万亿晶体管的 WSE-3 为 Cerebras CS-3 AI 超级计算机提供动力,通过 900,000 个 AI 优化计算核心提供 125 千万亿次峰值 AI 性能。值得注意的是,这是半导体代工合作伙伴台积电目前可以生产的最大尺寸。

从该公司CEO Andrew Feldman过去多年的采访可以看到,这位Cerebras Systems掌舵人对英伟达充满着“敌意”(或者说酸?)。考虑到英伟达过去几年的表现,这可以理解的。为此,在过去一直在强攻训练市场之后,Cerebras Systems往推理市场,发起新一轮的冲击。

颠覆传统,推出“全球最快” AI 推理服务

熟悉行业的读者应该知道,在许多现代生成式 AI 工作负载中,推理性能通常取决于内存带宽,而不是计算。将比特传入和传出高带宽内存 (HBM) 的速度越快,模型生成响应的速度就越快。

Cerebra Systems 的首款推理产品基于其之前发布的WSE-3 加速器,打破了这一争论。这是因为与 HBM 不同,餐盘大小的硅片非常大,以至于这家初创公司表示,它已经成功封装了 44GB 的 SRAM,带宽为 21 PBps。从这个角度来看,单个 Nvidia H200 的 HBM3e 仅拥有 4.8TBps 的带宽。

据首席执行官 Andrew Feldman (安德鲁·费尔德曼)介绍,通过使用 SRAM,该部件在以 16 位精度运行 Llama 3.1 8B 时每秒能够生成 1,800 个以上的token,而性能最高的 H100 实例每秒最多可生成 242 个token。

当运行分布在其四个 CS-3 加速器上的 700 亿参数版本的 Llama 3.1 时,Cerebras 声称每秒可处理 450 个token。相比之下,Cerebras 表示 H100 所能处理的最佳速度是每秒 128 个token。

费尔德曼认为,这种性能水平就像宽带的兴起一样,将为人工智能的采用开辟新的机会。“今天,我认为我们正处于人工智能的拨号时代,”他说,并指出生成式人工智能的早期应用,其中提示的响应会明显延迟。

他认为,如果你能足够快地处理请求,那么基于多个模型构建代理应用程序就可以避免延迟问题。Feldman 认为这种性能的另一个好处是允许 LLM 通过多个步骤迭代他们的答案,而不是直接给出他们的第一个响应。如果你能足够快地处理标记,那么你就可以掩盖这是在幕后发生的事实。

但是,尽管每秒 1,800 个token可能看起来很快,事实也确实如此,但经过简单的计算我们发现,如果不是因为系统计算能力受限的话,Cerebra 的 WSE-3 应该能够以更快的速度吐出token。如上所说,该产品代表了 Cerebras 的一点转变,迄今为止,该公司主要专注于 AI 训练。然而,硬件本身并没有真正改变。Feldman表示r,它使用相同的 WSE-3 芯片和 CS-3 系统进行推理和训练。而且,这些并不是没有达到训练要求的废弃部件——我们问道。

“我们所做的是扩展了编译器的功能,使其能够同时在芯片上放置多层,”费尔德曼说。

有分析人士直言,Cerebras 的 AI 推理服务不仅加速了 AI 模型的执行速度,还可以改变企业对在现实应用中部署和与 AI 交互的看法。

分析人士表示,在典型的 AI 推理工作流程中,大型语言模型(例如 Meta 的 LLaMA 或 OpenAI 的 GPT-4o)都存放在数据中心,应用程序编程接口 (API) 会调用它们来响应用户查询。这些模型非常庞大,需要大量计算资源才能高效运行。GPU 是当前 AI 推理的主力,承担着繁重的任务,但它们在这些模型的重压下苦苦挣扎,尤其是在模型内存和计算核心之间移动数据时。

但借助 Cerebras 的新推理服务,模型的所有层(目前是 80 亿参数版本和 700 亿参数版本的 LLaMA 3.1)都直接存储在芯片上。当向模型发送提示时,数据几乎可以立即得到处理,因为它不必在硬件内长距离传输。

值得一提的是,这种性能水平已由提供独立 AI 模型分析的 Artificial Analysis Inc.验证,是前所未有的,为 AI 推理树立了新标准。Artificial Analysis Inc. 联合创始人兼首席执行官 Micah Hill-Smith 表示:“Cerebras Inference 的速度突破了性能边界,而且价格极具竞争力,因此对于具有实时或大容量需求的 AI 应用开发者来说尤其具有吸引力。”

Hill-Smith 进一步指出:“对于 Meta 的 Llama 3.1 8B 和 70B AI 模型,Cerebras 的速度比基于 GPU 的解决方案快一个数量级。”“我们在 Llama 3.1 8B 上测量到每秒输出token超过 1,800 个,在 Llama 3.1 70B 上测量到每秒输出token超过 446 个——这些基准测试中创下了新纪录。”

它的价格也很有竞争力,Cerebras 表示,该服务的起价仅为每百万个token 10 美分 – 相当于 AI 推理工作负载的性价比高 100 倍。他们补充说,Cerebras Inference 服务特别适合“agentic AI”工作负载,即可以代表用户执行任务的 AI 代理,因为此类应用程序需要能够不断提示其底层模型。

SRAM,突破极限的武器

据相关报道所说,Cerebras之所以能达成这个成就,与他们独特的设计有关。

众所周知,当今推理速度受限于连接 GPU 和内存及存储的网络瓶颈。连接内存和核心的电路每单位时间只能传输有限量的数据。虽然电子在导体中移动迅速,但实际数据传输速率受到信号可靠发送和接收频率的限制,并受到信号衰减、电磁干扰、材料特性以及数据传输所必须经过的线路长度的影响。

而在传统的 GPU 设置中,模型权重存储在与处理单元分开的内存中。这种分离意味着在推理过程中,需要通过细线在内存和计算核心之间不断传输大量数据。Nvidia 和其他公司尝试了各种配置来最大限度地缩短这些数据需要传输的距离——例如,在 GPU 封装中将内存垂直堆叠在计算核心之上。

Cerebras 的新方法从根本上改变了这一模式。Cerebras 不是将晶体管核心蚀刻到硅晶片上并将其切成芯片,而是在单个晶片上蚀刻多达 900,000 个核心,从而无需在各个芯片之间进行外部布线。WSE 上的每个核心都结合了计算(处理逻辑)和内存(静态随机存取存储器或 SRAM),形成一个独立的单元,可以独立运行或与其他核心协同运行。

模型权重分布在这些核心上,每个核心存储整个模型的一部分。这意味着没有一个核心可以容纳整个模型;相反,模型被拆分并分布在整个晶圆上。

“我们实际上将模型权重加载到晶圆上,所以它就在核心旁边,”Cerebras 产品和战略高级副总裁 Andy Hock 解释道。这种配置允许更快的数据访问和处理,因为系统不需要通过相对较慢的接口不断地来回传送数据。

Cerebras 表示,其架构在 LLaMA 3.1 等模型的推理性能方面可以达到“市场上其他产品 10 倍”,尽管这还有待进一步验证。重要的是,Hock 声称,由于 GPU 架构的内存带宽限制,“实际上没有多少 GPU 可以像我们一样快速完成这些推理任务”。

通过优化大型模型的推理,Cerebras 正在定位自己以满足快速增长的市场对快速、高效的 AI 推理能力的需求。

换而言之,这种设计从某种程度上是让SRAM去取替更昂贵的HBM。虽然 SRAM 在性能方面明显优于 HBM,但它的不足之处在于容量。对于大型语言模型 (LLM) 来说,44GB 根本不够,因为您还必须考虑到键值缓存在 Cerebras 所针对的高batch sizes下占用了相当大的空间。Meta 的 Llama 3 8B 模型是 WSE-3 的理想化场景,因为大小为 16GB(FP16),整个模型可以装入芯片的 SRAM 中,为键值缓存留下大约 28GB 的空间。

Feldman 声称,除了极高的吞吐量之外,WSE-3 还可以扩展到更大的batch sizes,但对于它究竟能扩展到多大程度并维持每个用户的token生成率,这家初创公司不愿透露。

“我们目前的batch sizes经常变化。我们预计第四季度的batch sizes将达到两位数,”Cerebras 告诉我们。

当被问及更多细节时,该公司补充道:“我们目前的batch sizes还不成熟,所以我们不想提供它。该系统架构设计用于高batch sizes,我们预计在未来几周内实现这一目标。”

与现代 GPU 非常相似,Cerebras 通过在多个 CS-3 系统上并行化模型来解决这一挑战。具体来说,Cerebras 使用管道并行性将模型的层分布在多个系统上。例如对于需要 140GB 内存的 Llama 3 70B,该模型的 80 个层分布在通过以太网互连的四个 CS-3 系统上。正如您所预料的,这确实会降低性能,因为数据必须跨越这些链路。

在高带宽内存和计算核心之间每秒也只能传输大约 3 TB 的数据。这远远低于高效运行大型语言模型所需的每秒 140 TB 的速度,而这种速度是高吞吐量的,不会遇到重大瓶颈。Cerebras声称:“我们内存和计算之间的有效带宽不仅仅是 140 TB,而是每秒 21 PB。”

从这些介绍可以看到,Cerebras能否撬动英伟达不知道,但第一个受害者,已经跃然纸上,那就是早阵子引起广泛讨论的Groq。

Groq,首当其冲

从设计上看,Groq 的语言处理单元 (LPU) 实际上采用了与 Cerebras 类似的方法,即依赖 SRAM。

Groq 并不是 AI 芯片领域的新手,它由谷歌 TPU 的最初创造者 Jonathan Ross 在 2016 年创立。但 Groq 不仅仅是更好的 TPU。Ross 和他的团队开发了一种新的架构,最初称为张量流处理器 (TSP),但现在更名为语言处理单元(LPU),再次获得良好的营销效果!TSP/LPU 是一个巨大的芯片大小的内核,使用一种新颖的策略:确定性计算,可以非常高效地提供大量的 FLOPS。

Groq 的主要架构优势在于他们开发了一种完全确定性的架构,完全由软件控制。这实际上意味着什么?为什么它更有效率?因为大多数应用程序都是非确定性的。例如,想想文字处理器。文字处理器不知道您要输入的下一个字母,因此它必须准备好响应它收到的任何输入。事实证明,现代芯片的很多复杂性都来自于能够处理非确定性计算。

Groq 卡实际上没有片外内存。每个芯片上有 220 MB 的 SRAM,仅此而已。这意味着,如果您想运行大型模型,您需要很多芯片。要运行 LLaMA-70B,Groq 使用了 576 个芯片。对于 70B 参数模型来说,这相当于 8 个机架。对于类似GPT-4 等拥有 1.76 万亿个参数的模型,要在 Groq 系统上运行它,你需要超过 10,000 个芯片。每个机架包含 72 个芯片,因此每个 GPT-4 类系统实例需要 100 多个机架。此外,在这种规模下,将所有这些芯片联网开始增加瓶颈——目前,Groq 的光学互连只能扩展到 264 个芯片,而不是 10,000 个。这正是Groq与Cerebras的不同之处——Groq 的架构 SRAM 密度较低,因此需要通过光纤连接更多加速器来支持任何给定的模型。

Cerebras 需要四个 CS-3 系统才能以每秒 450 个token的速度运行 Llama 3 70B,而 Groq此前曾表示,它需要 576 个 LPU 才能突破每秒 300 个tokern的速度。Cerebras 引用的人工分析 Groq 基准略低,为每秒 250 个token。

Feldman 还指出,Cerebras 无需借助量化就能做到这一点。Cerebras 认为 Groq 使用 8 位量化来实现其性能目标,这减少了模型大小、计算开销和内存压力,但代价是准确性有所下降。

与 Groq 类似,Cerebras 计划通过与 OpenAI 兼容的 API 提供推理服务。这种方法的优势在于,已经围绕 GPT-4、Claude、Mistral 或其他基于云的模型构建应用程序的开发人员无需重构其代码即可整合 Cerebra 的推理产品。

在成本方面,Cerebras 也希望以每百万token 60 美分的价格提供低于竞争对手的 Llama3-70B。而且,如果你想知道,这是假设输入与输出token的比例为 3:1。

相比之下,Cerebras 在竞争云上为 H100 提供相同模型的成本为每百万token 2.90 美元。不过,与 AI 推理一样,有很多旋钮和杠杆可以转动,直接影响提供模型的成本和性能,因此对 Cerebra 的说法持保留态度。

然而,与 Groq 不同的是,Feldman 表示 Cerebras 将继续为某些客户提供内部部署系统,例如那些在严格监管的行业运营的客户提供内部部署系统。

虽然 Cerebras 可能比竞争加速器具有性能优势,但其支持的模型仍然有些有限。在发布时,Cerebras 支持 Llama 3.1 的 80亿 和 700 亿参数版本。不过,这家初创公司计划增加对 4050亿、Mistral Large 2、Command R+、Whisper、Perplexity Sonar 以及自定义微调模型的支持。

绕开了英伟达最大门槛?

如报道所说,Nvidia 之所以能牢牢占据 AI 市场,原因之一是其在计算统一设备架构(CUDA:Compute Unified Device Architecture)方面的主导地位,这是其并行计算平台和编程系统。CUDA 提供了一个软件层,让开发人员可以直接访问 GPU 的虚拟指令集和并行计算元素。

多年来,Nvidia 的 CUDA 编程环境一直是 AI 开发的事实标准,并围绕它建立了庞大的工具和库生态系统。这造成了一种情况,即开发人员经常被锁定在 GPU 生态系统中,即使其他硬件解决方案可以提供更好的性能。

Cerebras 的 WSE 是一种与传统 GPU 完全不同的架构,需要对软件进行调整或重写才能充分利用其功能。开发人员和研究人员需要学习新工具和潜在的新编程范例才能有效地使用 WSE。

Cerebras 试图通过支持 PyTorch 等高级框架来解决这个问题,让开发人员更容易使用其 WSE,而无需学习新的低级编程模型。它还开发了自己的软件开发工具包,以允许进行低级编程,可能为某些应用程序提供 CUDA 的替代方案。

但是,通过提供不仅速度更快而且更易于使用的推理服务(开发人员可以通过简单的 API 与其进行交互,就像使用任何其他基于云的服务一样),Cerebras 使刚刚加入竞争的组织能够绕过 CUDA 的复杂性并仍然实现顶级性能。

这符合行业向开放标准的转变,开发人员可以自由选择最适合工作的工具,而不受现有基础设施限制的束缚。

对于这个的未来,大家怎么看啊?

文章来源于“半导体行业观察”,作者“编辑部”

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则