2024年,落地,无疑是大模型最重要的主题。

尽管最新推出的拥有千亿参数和十万上下文的大模型在效果上取得了显著进展,但它们高达数百万的入门门槛、昂贵的推理成本和漫长的响应延时仍然严重阻碍了这些模型在实际场景中的应用。

优化成本,成了AI产业上下游共同的命题。

2024年5月,由幻方量化旗下的模型公司“深度求索”发布的大模型DeepSeek V2,其效果接近 GPT-4 。但两千多亿的参数使得其推荐部署门槛高达 8 块 80GB 的 A800/H800 显卡。

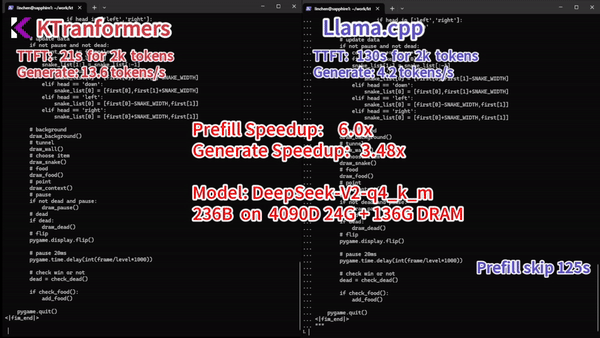

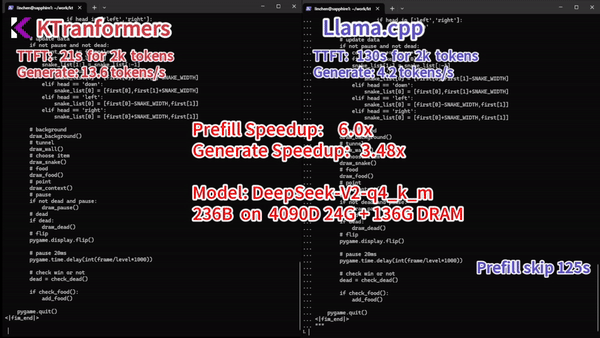

而近期,一家AI Infra公司联合清华大学KVCache.AI团队发布了开源项目KTransformers:仅用一张24GB的消费级显卡就成功驱动了具有236B参数量的DeepSeek V2大模型,实现了14 Tokens/秒的生成速度——这意味着,2千亿大模型的使用门槛降低到4万以内。

△KTransformers对比Llama.cpp运行速度。

这一成果在国内外用户社区引发了广泛的反响,也被Hugging Face开源项目负责人Lysandre Debut点了赞。

△Lysandre Debut的动态。

背后,这家名为“趋境科技(Approaching.AI)”的AI Infra公司,浮出了水面。

《智能涌现》获悉,趋境科技近期完成了天使轮融资,由真知资本独家投资。公司主要围绕RAG(检索增强生成)等最主要的大模型应用场景,使用的创新策略,不仅能优化算力利用率,还能将大模型本地化部署的落地成本降低10倍,响应延迟降低20倍,有效解决大模型公司以及金融、安全、电信、教培等行业大模型落地的“最后一公里”难题。

成立于2024年初,趋境科技由真知创投创始人任旭阳、清华大学计算机科学与技术系教授武永卫联合发起,公司核心三人创始团队艾智远、陈超、陈祥麟均出身武永卫门下,在AI和存储相关的技术系统和软件领域,有多年学术与产业实践经验。

CEO艾智远为清华大学博士,曾在上市公司深信服担任多部门研发主管,专长于分布式系统优化、并行计算、分布式存储等领域。首席战略官陈超,清华大学工程博士在读,拥有MIT&杜克大学双硕士,同时兼任真知创投董事总经理,负责真知创投技术驱动项目的孵化与投资。研发负责人陈祥麟,清华大学硕士,拥有多年大数据与AI相关产品研发和落地经验。

而趋境科技的长期技术合作方,是清华大学的KVCache.AI团队。团队负责人章明星同样是武永卫的学生,曾担任深信服首席算法技术专家和创新研究院院长,并在系统领域发表数十篇顶级会议论文。

此前 KVCache.AI也曾与AI独角兽月之暗面,共同发布了人工智能助手Kimi底层的Mooncake模型推理架构。这一架构承载了Kimi 80%以上的实际线上流量,在某些模拟场景中,吞吐量可以增加到未优化场景的5.25倍。

△Mooncake论文。

承接算力层和应用层,提高底层芯片的利用率、让模型的训练和推理更高效,是AI Infra在AI落地过程中主要扮演的角色。

早在2023年,AI Infra已经聚集了一批明星玩家。在大厂,开源的深度学习训练框架是主流,Meta有PyTorch,谷歌有TensorFlow,百度有PaddlePaddle。而在创业赛道,Infra也汇聚了袁进辉的硅基流动、尤洋的潞晨科技等明星公司。

2024年入场的趋境科技,会不会姗姗来迟?趋境科技团队告诉《智能涌现》:就AI推理的市场而言,AI Infra公司仍处于竞合态势的早期阶段,面对的是一个尚待培育的蓝海市场。

更重要的是,趋境科技选取了特定的RAG(检索增强生成)场景——在趋境科技团队看来,RAG是大模型落地最广泛的场景,“针对RAG场景提出崭新的“以存换算”优化思路,同时有更加专注和实际落地导向的策略。”

“推理端的优化,天花板比训练端更高”

AI Infra的主要优化方向,是模型的训练和推理过程。

大模型训练,包括参数调优、数据训练等环节,让模型具备执行相应任务的能力。2023年,在大炼模型的背景下,目前主流的Infra玩家,比如大厂、硅基流动和潞晨科技,都位于训练优化这一层,帮助下游客户提高训练效率、降低训练成本。

趋境科技告诉《智能涌现》,随着模型架构逐渐收敛于Transformer及其变种,训练优化的技术壁垒和提升空间正在缩小。事实上,大多数模型的算力利用率(MFU)已经超过50%,而领先企业与开源框架之间的差距也不超过10%。

相比之下,推理端的优化则蕴含更大的潜力。趋境科技团队表示,推理过程直接影响到模型在实际应用中的决策和任务执行能力,决定了AI技术能否真正为企业带来实际价值。

2023是模型训练的元年,2024年则是模型推理的元年。随着AI应用场景的多样化,推理端的优化空间更为广阔而富有挑战,这正是趋境科技决定在此时入场的原因。

趋境科技原创的推理端优化路径,是名为“以存换算”的思路。通过将历史知识进行模块化预处理,同时将其处理的中间结果提前缓存,在实际的使用过程中仅需少量计算即可响应用户需求。

这一方案能够将RAG(检索增强生成)场景下的推理成本降低10倍,响应时延降低20倍。

先瞄准大模型应用最广泛的场景:RAG(检索增强生成)

具体到落地场景,B端客户的RAG(检索增强生成),是趋境科技Infra主要瞄准的领域。

看起来高深的RAG,其实是时下大模型应用最为广泛的一个场景。所谓的RAG,就像是给大模型外挂了一个专业数据库,当大模型需要处理复杂的专业任务时,就会优先检索相关数据,从而显著提高响应速度和准确性。常见的知识库问答系统、智能客服等领域,都离不开RAG。

而从RAG场景切入的原因在于,一方面,RAG为后续产品规模化提供了一个广阔的市场,据陈超介绍,RAG在大模型落地场景的占比,达到了70%左右。

另一方面,趋境科技仍处于建立品牌认知阶段,从大场景切入,有助于客户建立品牌认知。

在这一场景下,趋境科技为B端客户提供的解决方案是一套集成了芯片、大模型等软硬件的AI知识库推理一体机。

这个端到端的解决方案采用了趋境科技原创的“以存换算”思路。与此同时,根据客户的具体需求,该方案通过组合不同厂商的芯片、模型,提供最低成本的部署选项。

下一个模型大规模落地的场景是什么?趋境科技给出的答案是:多模态RAG。团队告诉《智能涌现》,无论是图像识别还是语音交互,多模态技术都将在企业业务中扮演不可或缺的角色。目前,趋境科技已经开始布局该领域,预计明年将推出多模态RAG解决方案。

以下是两位发起人的评价:

趋境科技发起人、真知创投创始人兼董事长任旭阳表示:

趋境科技另辟蹊径采用“以存换算”的技术路径,大幅降低大模型部署成本的同时显著提升性能,为大模型应用的快速普及铺平道路。真知创投携手清华系顶尖技术团队联合创立趋境科技。我们期待这支“企业家+科学家”的 AI Infra团队能够持续引领创新,帮助企业以前所未有的低成本和高效率应用大模型!

趋境科技发起人,清华大学计算机科学与技术系长聘教授、IEEE Fellow 武永卫表示:

大模型正在深刻变革信息供给的模式,同时我们也面临核心计算硬件的高墙壁垒,从计算机系统的角度出发,通过软硬协同的存算平衡设计,大幅提升给定计算硬件的效能是一条破局之路。趋境科技以计算机系统创新为切入点,专注于大模型推理应用的极致效能,值得期待。

文章来源“ 智能涌现“,作者” 智能涌现“

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则