扎克伯格预测,Meta AI助手使用率几个月后将超越ChatGPT。

7月24日凌晨,美国科技巨头Meta推出迄今为止性能最强大的开源大模型——Llama 3.1 405B(4050亿参数),同时发布了全新升级的Llama 3.1 70B和8B模型版本。

Llama 3.1 405B支持上下文长度为128K tokens,是全球迄今为止性能最强大、参数规模最大的开源模型,在基于15万亿个tokens、超1.6万个H100 GPU上进行训练,这也是Meta有史以来第一个以这种规模进行训练的Llama模型。

因性能佳、开源、多方合作,目前所有Llama模型版本的总下载量已经超过3亿次。研究人员基于超150个基准测试集的评测结果显示,Llama 3.1 405B可与GPT-4o、Claude 3.5 Sonnet和Gemini Ultra等业界头部模型相媲美,包括亚马逊AWS、英伟达、微软Azure和谷歌云等25家头部公司与Meta达成合作,引入Llama 3.1。

“这对于我们来说是久旱逢甘霖。”独立分析师Jimmy告诉《中国企业家》。苦于缺乏长期高质量的训练数据已久,全球AI领域的开发人员终于迎来了开源曙光。一般来说,较小的专家模型(参数规模在10亿~100亿)通常利用“蒸馏技术”,也就是利用更大的模型来增强训练数据。但由于巨头OpenAI的闭源,此类训练数据的缺乏是各大模型共同的难题。

开、闭源之争一直是AI圈的中心话题。Meta创始人、CEO扎克伯格提到:“我相信Llama 3.1的发布将成为行业的一个转折点”;360集团创始人周鸿祎也曾表示,开源社区聚集全球上千家公司、数十万程序员和工程师,开发力量是一个闭源公司的数百倍。

扎克伯格开源Llama 3.1,逼急OpenAI

Meta公布前一天,Llama 3.1的模型和基准测试结果已经在国外的Reddit等社区上泄露,Llama 3.1的磁力链接也被流传,“强大”“开源”成为评论区的高频词。

Llama 3.1包含8B、70B和405B三种参数规模,其中超大杯4050亿版本,该系列模型上下文窗口增加到了128K,扩大16倍;增加了8种支持语言;提升了工具使用能力,支持搜索和Wolfram Alpha的数学推理;拥有更宽松的许可,允许使用模型输出改进其他LLMs。

事实上,开、闭源的大模型差距正在缩小。Meta在官博指出最新一代的Llama将激发新的应用程序和建模范式,包括利用合成数据生成来提升和训练更小的模型,以及模型蒸馏——这是一种在开源领域从未有过的能力。在基准测试集中的表现几乎可以媲美当前顶尖闭源模型GPT-4o和Claude 3.5 Sonnet,并且所有版本都可以在官网下载使用。

Meta对Llama 3.1的布局在今年4月就有迹可循。当时Meta就透露说,正在开发人工智能行业的第一款产品:一个性能与OpenAI等公司最好的私有模型相媲美的开源模型。

相比于OpenAI对技术细节的“惜字如金”,Meta此次不仅开放小助手应用在线试玩,还发布了近100页的详细论文,涵盖了创造Llama 3.1过程中的一切,比如训练数据、过滤、退火、合成数据,并透露Llama 4已在开发中。

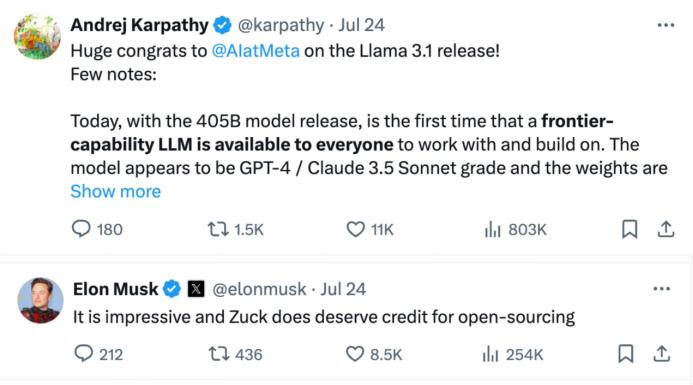

扎克伯格亲自为开源大模型Llama 3.1站台,在推特撰写长文《Open Source AI Is the Path Forward》强调开源的意义,他表示:“今天我们正迈出下一步——使开源AI成为行业标准。”在特斯拉前AI总监关于Llama 3.1大模型的帖子下面,马斯克罕见地盛赞扎克伯格:“这令人印象深刻,扎克(伯格)的开源决定确实值得赞扬。”

来源:马斯克回复推特截图

Meta与OpenAI分别代表着开源与闭源的两条技术路线。关于开源和闭源的斗争由来已久,此前在彭博社的采访中,扎克伯格更是公开嘲讽:“阿尔特曼的领导能力值得称赞,但有点讽刺的是公司名为OpenAl却成为构建封闭式人工智能模型的领导者。”

来源:彭博社X(原推特)截图

面对Meta这次的大招,OpenAI以低价策略应战。

Meta公布Llama 3.1两个多小时后,OpenAI发布消息:公司推出了GPT-4o mini微调功能版,从现在到9月23日可免费使用。据了解,GPT-4o mini的输入tokens费用比GPT-3.5 Turbo 低90%,输出tokens 费用低80%。即使免费期结束,GPT-4o mini的价格也比GPT-3.5 Turbo低一半。

价钱打折,但产品能力不打折。据了解,GPT-4o mini比经典版本GPT-3.5 Turbo能力更强,GPT-4o mini的上下文长度为65k tokens,是GPT-3.5 Turbo的四倍,推理上下文长度为128k tokens,是GPT-3.5 Turbo的八倍。

这就意味着,若使用GPT-4o mini微调版,就可以享受:以实惠的使用费用,使用更长的上下文、更聪明的顶尖大模型。阿尔特曼更是在推特发文表示,GPT-4o mini以1/20的价格在lmsys上实现了与GPT-4o接近的性能表现,他还希望大家能够多多使用GPT-4o mini 微调版本。

此次OpenAI以发布GPT-4o mini 微调版为盾,不仅是对Meta开源大模型步步紧逼的反击,也同时将硅谷AI价格战的火药味推得更浓。

用价格“围剿”OpenAI

即使OpenAI推出可免费使用的小模型,但比起同为大模型的产品,Llama 3.1 405B的价格比GPT-4o仍然要低很多。

公开数据显示,Llama 3.1的价格在Fireworks平台上是每1百万tokens的输入/输出价格是3美元,而GPT-4o每1百万tokens的输入价格是5美元,输出价格是15美元。此外,Claude 3.5 sonnet的每1百万tokens的输入价格是3美元,输出价格是15美元。

这不是硅谷在AI方面的第一次“价格战”。

今年5月,OpenAI发布GPT-4o并支持免费试用,调用API的价格也比GPT-4-Turbo降低一半——打响了硅谷大模型价格战第一枪,同时这也是2023年起OpenAI的第4次降价。7月18日深夜,GPT-4o mini的正式亮相,与GPT-3.5相比性能更强,也更便宜,连阿尔特曼都曾建议大家不要再用GPT-3.5了。

用低价“围剿”OpenAI已成大模型公司们的惯例。公开信息显示,与GPT-4o相比较,各大公司的最新发布的产品分别是:Meta的Llama 3.1,谷歌的Gemini 1.5 pro,Claude 3 Sonnet,新近的Mistral AI,这些最新大模型价格均低于GPT-4o。

国际头部大模型公司产品价格表,信息来源各大模型官网。制表:孙欣

而大模型的价格战在国内也已开始。5月6日,初创大模型公司DeepSeek深度求索将输入价格定为1元/百万tokens。紧接着智谱AI的GLM-3-Turbo模型、字节跳动的豆包大模型,以及阿里巴巴的通义系列模型、百度的文心一言模型纷纷跟牌。

低价,正在成为一种趋势。

小模型或将成为AI新风口

一直以来,大模型的发展受困于成本。斯坦福HAI研究所发布的《斯坦福2024年人工智能指数报告》指出,AI模型的培训成本已经达到了前所未有的水平。例如,OpenAI的GPT-4估计使用了7800万美元用于计算训练,而谷歌的Gemini Ultra花费了1.91亿美元用于计算。2017年训练最初的Transformer模型的成本仅为约900美元。

而现在,小模型成了AI公司们降本增效的利器。

掀起新一轮价格战前,OpenAI先手开卷小模型。7月18日,OpenAI发布小模型GPT-4o mini,并称其为“迄今为止最具成本效益的小模型”,正是上周(北京时间7月25日凌晨)宣布免费使用的GPT-4o mini微调版的真身;苹果公司在Hugging Face上发布了DCLM-7B开源小模型;不久后,英伟达和法国明星AI独角兽Mistral联合发布了名为Mistral NeMo的小模型,称可以直接替换任何使用Mistral 7B的系统。

小模型,通俗来说就是比大模型处理数据能力略小的模型,可以理解为mini版的大模型。在AI领域,参数规模越大,大模型学习能力越强,诸如GPT-4这些模型通常拥有数十亿甚至数百亿的参数。然而据OpenAI介绍,小模型GPT-4o mini在MMLU上的得分为82%,甚至某些表现优于大模型GPT-4。

对大部分用户来说,小模型是大模型的“平替”,极具性价比。尽管小模型在处理复杂任务上不具优势,但在小任务上具备更快的推理能力。同时对计算机存储需求也更小,耗能也更小。根据各公司的大、小模型产品对比来看,小模型价格较低。根据Artificial Analysis的统计,美国AI公司主流“小模型”中,GPT-4o mini的价格最低,在无需处理复杂任务的“普通用户”中或许将更受欢迎。

低价来自成本的降低。阿尔特曼在推特上发文指出,2022年世界上最好的模型text-davinci-003,它比GPT-4o mini差得多,但成本要贵上100多倍。这一波OpenAI抢先布局小模型,就是想通过显著降低AI使用成本,扩大AI使用范围。

来源:阿尔特曼推特截图

低成本、低性价比、更广用户适配度,小模型不仅能成为AI公司们to C端的有力手段,更是AI价格战的应对神器,或将成为下一个新风口。

今年年初,2024百度AI开发者大会上,李彦宏提出未来大型的AI原生应用都是大小模型的混用。他还表示,用户基于百度文心4.0,可以灵活剪裁出适用于不同场景的小尺寸模型,“在一些特定场景中,经过精调后的小模型,其使用效果甚至可以媲美大模型。”

国外GPT-4o、Llama 3.1轮番轰炸,国内“千模大战”大浪淘沙,无论开源还是闭源,高价还是低价、大模型还是小模型,这波AI浪潮最后的胜者还未显现。

参考资料

扎克伯格《Open Source AI is the Path Forward》,原文链接: https://www.facebook.com/zuck

Meta《Meta Large Language Model Compiler: Foundation Models of Compiler Optimization》,原文链接: https://ai.meta.com/research/publications/meta-large-language-model-compiler-foundation-models-of-compiler-optimization/

本文来自微信公众号“中国企业家杂志”(ID:iceo-com-cn),作者:孙欣

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则