2024年了,被寄予厚望的AI Agent,到底是谁在用啊?!

它被视作通向AGI最有可能的路径之一,国内外公司都研究得火热,虽然似乎一切只是“押注”,但据我们所知,有不少toB领域已经喜提Agent了。

为什么是toB领域先用上?量子位询问了一位创业者,他所创立的AI Agent公司正在为toB领域的许多场景提供服务。

AI Agent可以被视作管理者跟基础员工、专家跟基础员工,员工与员工之间的连接器,能够填充企业想做数字化转型时,所面临的人和系统之间的空间。

同时他也提到,受目前技术所限,AI Agent不仅需要和一些传统技术,比如搜索规则引擎、知识图谱等进行组合。

更重要的是,Agent必须要知道自己在什么样的环境、什么样的场景下能够起作用。

恰巧,这位创业者——澜码科技创始人兼CEO周健,刚刚在上海正式发布了团队自主研发的AI Agent平台AskXBOT。

我们决定以这个平台为一个案例,来个顺藤摸瓜,好好探一探Agent现在的进展。

Agent平台AskXBOT

澜码AskXBOT的自我定义,是一个AI Agent平台。

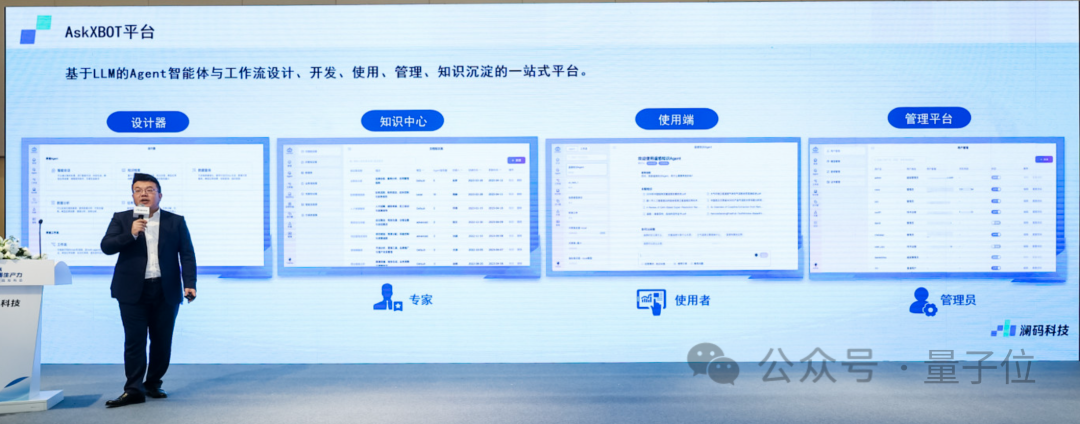

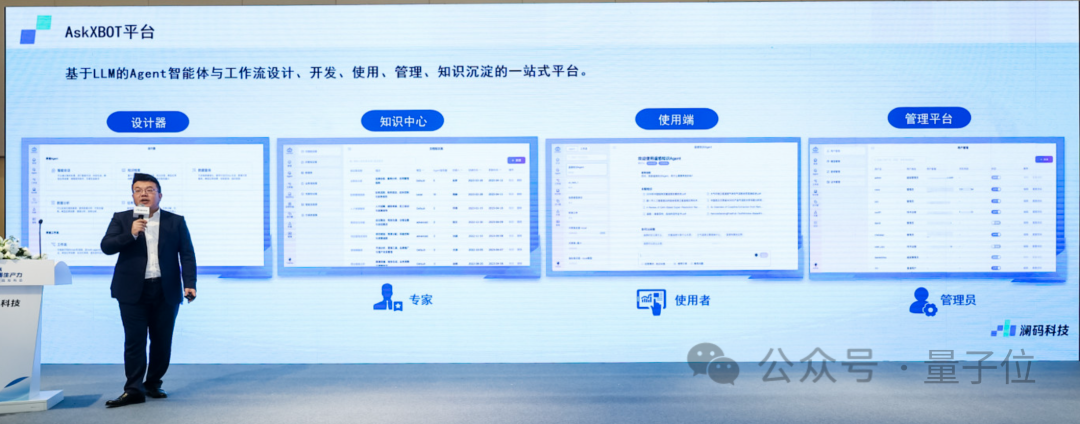

再详细展开一点,AskXBOT是基于大语言模型的Agent与工作流设计、开发、使用、管理、知识沉淀的一站式平台。

从整体结构来看,AskXBOT的设计并不繁琐,它主要由四个部分组成,分别是设计器、使用器、管理平台以及知识中心,为企业提供文档检索、AI调用、数据查询、智能编程等基础能力。

设计器用于创建和管理AI Agent。在这里,用户可以通过拖、拉、拽的无代码方式,设计和配置所需的AI Agent的模版,即使是没有技术背景,不会写代码的用户,也能轻松创建符合要求的Agent。

使用器则是提供用户和Agent交互的界面,在这里,用户可以和Agent对话,让Agent获取信息,从而进一步执行任务。

顾名思义,管理平台的主要功能是提供监管工具,包括权限控制、性能监控、日志分析等,用这些功能确保Agent的运行安全、稳定,并在用户反馈的基础上持续优化。

而用来沉淀和组织知识资产的知识中心,被澜码科技视为核心差异化模块。专家可以把知识和经验输入知识中心,被Agent学习后使用,以提供更准确的服务和响应。

实际工作中,专家用户的数据分析流程步骤和分析都非常丰富,理论上而言,专家可以把分析过程数据保存下来,做一个SOP(标准作业程序)。

那么,其他所有的中级或初级的业务人员,在不用对专家核心知识死记硬背的时候,就能把相应的标准操作分析过程重复一遍。

“任何一个专家,一天也只能提供24小时的智力和劳动力,不可能无限扩张。”周健举了个非常容易理解的例子,那就是现在用大模型能力,利用Agent,只要加算力,专家的经验知识就能够被复制。

这么来算的话,如果有30块显卡,一个专家的能力就能提供720小时不间断的服务。

于是就能理解周健坚信的,“如果没有专家把知识数字化下来, 那么AI Agent的落地会有很大的困难”。

而为了让Agent更好地落地,丝滑运用到各行各业,澜码团队提出了三步走的AI Agent构建法则:

第一步,专家知识数字化;

第二步,基于CUI(对话式用户交互界面)的柔性交互;

第三步,领域知识的循环沉淀。

2023年被普遍认为是大模型元年,而刚刚开始的2024年,则期望能大幅度拉开Agent发展的序幕。

周健表示,实际上澜码现在的设计思路,就是希望能够实现把Agent本身当成是一种生产力。

目前,AskXBOT已经有教育、人力资源、银行、国央企等许多合作客户。

拿人力猎头行业为例,北京人力华明科技公司、CGL等都是澜码AskXBOT的使用者。

在与CGL的合作中,澜码在其原有的猎头顾问系统中做了一个Copilot,让顾问不但能够高效地筛选、联系候选人,还能做一些原本不能完成的事情。

CGL高级副总裁郭雁冰表示,在实操中,专家作用远远超过数据,所以必须在专家知识上下功夫,做出能够模拟专家行为的Agent。

周健也希望能在下一个版本,让Agent拥有初步拥有对人才进行选、育、用、留的功能。

“Agent的落地速度比想象中更慢”

“让Agent有选、育、用、留功能,我们离可用技术实现这个阶段还有多远?”

“两年时间吧。”

打破砂锅问到底,我们终于知道了“2年”这个数是怎么被估算出来的。

周健的判断标准首先来自OpenAI。OpenAI在GPT-4问世时曾经提过,如果两年内有企业做AGI能做得比它强,它就会投降,并把知道的所有的方法告诉赢家。

憧憬一下,如果OpenAI突然祭出GPT-5,那时候在它基础上搭建一个AI Agent,是多么爽的一件事(doge)。

言归正传,现在离OpenAI的两年之约已经过去了一年,而周健自己判断2024年不管国内还是硅谷,都是AI大模型落地的元年,再往后一年的2025年,因为有落地案例,看到友商或者其他赛道有人已经落地,并且通过AI竞争大大增收,所以其他厂商肯定会跟进。

“这样的环境,再叠加GPT-5,所以我认为2025年肯定爆发,可能能真的用起来了。”周健笑道。

听起来,周健对未来预期的一切颇有底气,但是当话锋从未来两年转回过去一年时,他的态度是这样的——

现在年底往前看,大家落地的程度是比我年初想象中的判断要慢。

2023年3月,差不多是周健刚刚创业的时间,OpenAI发布ChatGPT Plugin,愁得他一宿没睡,满脑子都是“vocal,我要做的事情GPT做了怎么办?”

但是时间来到11月份,GPTs亮相的时候,周健自称这时候心态是了然于胸的、不慌不忙的。

原因只有一个,就是拜读3月轰动一时的论文《Sparks of Arti cial General Intelligence: Early experiments with GPT-4》后,周健当时的判断是GPT-4能够通用写50行到100行代码,“这其实是很可怕的,因为一个程序员一天大概也就写100行代码,那么GPT-4就能够代替一个程序员一天的工作量。”

基于这个设定,当时的周健很激进地认为,各个软件应该能够立刻马上原地被AI赋能,2023年年内就会开启淘汰赛,自己和团队的机会在比赛刚开始时就被大模型横扫了。

然而,后期团队与办公软件的合作过程,越做越让周健发现了一些不对劲:

通用写50行到100行代码这个预估,一下子把我忽悠瘸了。后面再认真仔细看GPT-4的论文,其实它大概也只能写2-3行代码,差距有十倍。

如果能力最强的GPT-4能写50-100行代码,那人类可能不剩下啥机会了。

但如果它只能写3、5行代码,你还基于它去做计划,那能做的任务决策的复杂度是十分受限的。

在正确看到真人程序员和GPT-4的差距,并且对算力有正确的认知后,澜码提供的私有化部署服务,就逐渐转变为小模型、大模型协同,加上作为入口的Root,把任务拆解出来,用不同的算力、调用不同的模型来解决这个问题。

翁丽莲的Agent公式是正确的吗?

所有关注Agent的人,几乎都见过OpenAI华人科学家翁丽莲给出的Agent配方:

Agent=大模型+记忆+主动规划+工具使用

曾几何时,周健也把这个Agent配方奉为圭臬,但随着澜码在AI Agent领域的实践增加,他有了略带不同的思考。

“现在大家一直在讲的具身智能、AI Agent、未来AGI,都是有能力和实际环境进行交互的。”周健向我们阐述了他的新观点新看法,他越来越觉得,Agent最重要的能力是和环境的互动能力。

当然了,工具使用可能还好,主动规划和常识记忆仍然是核心点,但最具有差异的点,可能是在于Agent能否与环境交互(interaction with environment),在于AI有没有探索环境的能力。

周健表达自己的观点,“如果它对环境没有感知,我觉得就不能叫Agent”。反过来说,能意识到环境是什么样,有哪些可被调用的工具,能去发现、去探索,这个能力很重要。

从这个角度来看,翁丽莲给出的配方,在周健心中更像是“现阶段妥协于技术限制的Agent”。

在周健这位AI Agent践行者眼中,是需要有一个Master Agent进行任务分发——当然,前提一定是对环境有感知,才能进行接下来的探索。

如果要到人机融身、人机融合或者说人机共生的地步,它(Agent)一定是需要自己能够感知环境的。

再视这个环境的大小,可以慢慢提升能力,最后回到Yann LeCun提到的世界模型。

当然了,比较遗憾的是,上述想法是周健和澜码团队近期才逐步琢磨出来的一个新的探究中心,在AskXBOT中并没有相应的设置和体现。

不过2024就在面前,在Agent的当打之年,Agent本身除了团队、数量节节攀升以外,或许能力也能涌现一波、突破一波?

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则