“当看到GPT4.0的时候,我的感觉就是自己喜欢的女生跟别人跑了。”

2024年3月14日,面对虎嗅,彩云科技CEO袁行远这样形容GPT4.0带给他的意外冲击。

那一天,OpenAI发布了GPT4.0,看到智能度明显超越彩云小梦的GPT4.0,袁行远感觉就像是“智能的果实被别人摘取了。”在此之前他们其实看到过那扇门,只是没有用全部资源走过去推开。

曾经,彩云科技是国内最早一批进行NLP(自然语言处理研究)的公司。2017年,彩云科技就已经开始做 NLP 和大模型方面的工作,到了2018年的时候,彩云科技训练出了一款知识问答机器人,在搜索数据集 MS MARCO 上获得了世界第一的成绩。2021年6月,袁行远提交了《自然语言编程方法》的全球专利。基于这些技术,2021年彩云科技推出了AI续写产品彩云小梦APP。上线一周,彩云小梦就获得接近 100 万用户。2021 年 5 月,彩云科技英文大模型在创造力和文笔的人工测评上,超越了 OpenAI 的 GPT3 英文版 davinci 模型。目前彩云小梦的全球用户累计400 万,国内用户每天用彩云小梦创作 4 亿字的文本。

正是因为彩云小梦曾经超前的语言能力,22年11月30日,一鸣惊人的GPT3.5引起大众广泛关注时,袁行远依旧没有为之震撼,因为他发现那时GPT3.5的写作能力并没有小梦强。

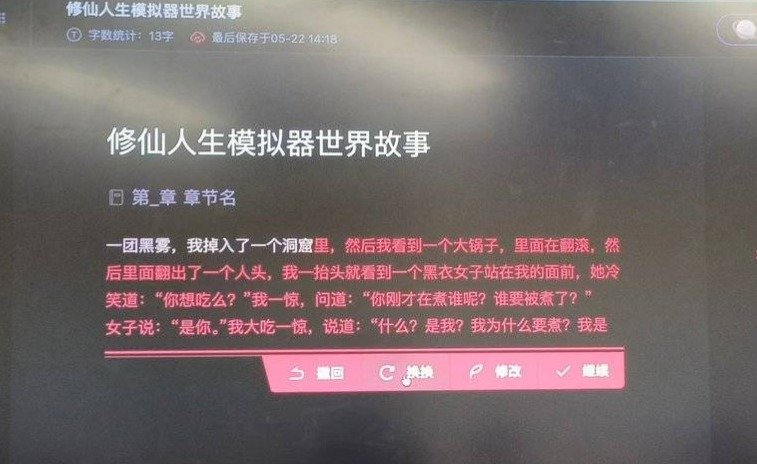

彩云小梦续写修仙小说,虎嗅拍摄

彩云小梦,让袁行远第一次感受到被00后用户簇拥的感觉:很多00后B站用户上传了用彩云小梦来跟卖茶女对线、续写《红楼梦》、写电影游戏剧本等视频,这些视频在B站上面逐渐形成了上亿的播放量。

有UP主用彩云小梦跟“卖茶女”骗子微信对线,吸收了简中互联网20余年语料的彩云小梦,成功实现了“魔法战胜魔法”,被小梦“疯狂调戏”的卖茶女暴露原型落荒而逃。

甚至,有用户一度疯狂吐槽击败卖茶女的彩云小梦背后是真人操控。

对于创立于4年前的彩云科技而言,此时此刻这家公司若隐若现地触摸到了成功的感觉。

但现在袁行远回想起那时的荣光,又像是一个温柔的诅咒:让他“方向错了”。

“每一次的成功经验也是你的诅咒”,这种繁荣阻碍了他获取第二次正确答案的机会。这是因为彩云小梦的文学创作方向具有极强的娱乐属性,并不需要高准确率——即便小梦回答得牛头不对马嘴,用户反而会觉得小梦很萌很天真。所以他们舍弃了本该All in的模型的知识性和扩大参数的方向,错过Scaling Law,错失突破AI临界点的果实。

这场遗憾也开启了彩云科技的一场豪赌。

袁行远痛定思痛,下定决心改进目前主流大模型架构Transformer的性能,来弥补此前的遗憾。袁行远认为,“像一些公司那样基于开源模型微调训练,然后宣称自己研发了一个大模型去打榜融资,是没有价值的”,因为这并不能提升模型本身的智能度,“在很多人都在做这个事情之后,我们就没有必要做这个事了。”

2024年5月22日,在海淀768创业产业园,虎嗅再次见到了袁行远。与上次见面相比,一年后的袁行远多了几分意气风发。

经过一年时间的打磨,袁行远兴奋又略带拘谨地向媒体展示他们的成果——全新通用模型架构DCFormer,通过改进Transformer计算最耗时的核心组件——多头注意力模块(MHA),他们推出的DCFormer将Transformer的计算性能达到两倍的提升。

在发布会之后,他坐到了我的面前,面对我的提问依旧回答得不假思索且坦诚直接。

但当我问他:“这项工作是否让他离喜欢的女生更近了?”

袁行远却停顿思索了一会,表示仍然“犹未可知”。

紧接着,他又补充了一句:“但这就像是原本以为自己就要输掉比赛的跑步选手发现,距离赛跑的终点AGI还有很长一段距离,那心态就会好一些。”(AGI:具备与人类同等智能、或超越人类的人工智能,能表现正常人类所具有的所有智能行为。)

他的迟疑似乎在变重。有围观的员工打趣“有天或许我们能超越GPT”时,袁行远马上纠正他的说法,并强调“我们现在的目标是追上GPT的尾灯。”

在我和袁行远三个小时的交流中,不断有员工加入和围观。和很多身处AI风口、公司和内心都迅速膨胀的创业者相比,袁行远和他的公司,多了几分接地气的松弛感。

比如,在彩云科技的一层分享区,摆放着PS5、桌游卡牌和随处可见的《三体》张贴画,甚至会议室名称都用自然选择、古筝计划等《三体》特有名词命名。这里的氛围比一般的科技公司更加轻松、开放。两个月前,彩云科技刚在这里举办了成立十周年生日庆典。

十年间,彩云科技推出了数款足够成熟和商业化的AI产品。2014年2月,在阿里上市前夕,袁行远辞去了高级广告算法工程师的工作,创建彩云科技后发布了彩云天气APP。这款袁行远在咖啡厅里写出的天气APP累计用户超过5000万,目前已经拥有滴滴、小米、饿了么等1000家企业客户。2017年1月,彩云科技推出了全球首个中英同传APP彩云小译,目前累计下载量达500万次,月活百万。

我很好奇袁,是如何去理解过去十年的:在这十年中,彩云科技开发的产品是目前少有的几款用户量突破千万层级的AI原生应用,但这与他们今天发布的DCFormer,并无直接关系,更像是为了袁行远的梦想而打造出的一个个“下蛋的鸡”。

袁行远向虎嗅展示了用户写给彩云天气的8924封来信,其中有看天吃饭的菜农、流动卖唱的流浪歌手、户外接单的外卖小哥,但在谈论起这几款千万用户级的产品时,袁行远并没有展示DCFormer时的那种兴奋与自豪。

这些产品产生的商业化营收,足够支撑袁行远去做彩云科技和自己的理想——这才是袁行远真正为之自豪的事情。

他似乎是个典型的理想主义者。他告诉我,如果人生是可以完全自由选择的,他或许会将所有精力投入到学术研究。但是世界并没有给他这样的机会,一个小公司的选择仍旧有限。似乎公司运营和商业化也是为了他真正喜欢的事情——学术研究,所付出的代价。他还告诉我,作为《三体》等科幻小说的死忠粉丝,他一直将AGI作为自己的终生目标,在AGI之前,他要先做出AI时代的杀手级应用——无限自由度的AI RPG游戏。

袁的这种理想主义,在AI工程师圈子里可能并不是主流,他像一个从实验室闯入商业世界的另类。这也吸引了彩云科技联合创始人、首席科学家肖达最初的加入,肖达的另一个身份是在彩云科技毗邻的高校——北京邮电大学任教。与在谈论”AGI、RPG游戏、同人文”时滔滔不绝的袁行远不同,肖达身上有着传统理工科出身严谨内敛的特质,大部分时间他的回答言简意赅、平和冷静。但作为DCFormer研究的主导者,他当时的表现似乎并没有袁行远那么兴奋。

一个理想主义者的冒险

回首DCFormer的最初诞生过程,对于那时的袁行远来说,就像用残破长矛勇敢迎战巨大风车的堂吉诃德一样无所畏惧。

因为这项研究前途并不明朗,并且在当时不能马上产生利润回报,但袁行远依然决定拿出100万美元投入。这对于当时年收入千万人民币的彩云科技来说,无疑是一项较为冒险的决定。董事会建议他再做一段时间的商业化,毕竟在那时他们还没有DCFormer这样的成果,这样的大手笔投入存在很高的解释成本,为了让公司和董事会接受,袁行远做了很多“功利性”的事情——他拿出了彩云小梦的产品DEMO,解释这个模型可以给小梦带来的无限可能性。

曾经,AI学术界不断迭代升级的技术路线就像接力赛,每隔一年或半年总会有更好的模型涌现。1998年,杨立昆提出了多层CNN卷积神经网络;2016年,最流行的是RNN循环神经网络的变种——LSTM;半年后,与其对标的Transformer横空出世。然而,人们预想的能够颠覆Transformer架构的新模型并没有出现。Transformer也像一个黑盒一样,直到现在学术界仍然无法完全解释它。

这些问题催生了袁行远的好奇心:Transformer是宇宙上最好的模型吗?它究竟为什么可以运行?它的能力边界在哪里?

于是2020年,彩云开始着手做一个在当时非常冷门的研究——模型可解释性。这也是因为:他们发现想要让Transformer变得更好,首先要从底层理解它、发现其中缺陷并进行改进。DCFormer就是他们对其改进的结果。

然而,突如其来的疫情,打乱了袁行远的原定计划。疫情下,足不出户的用户并不需要彩云天气这样的天气预报软件,拿不到广告收入的他们收入腰斩。2020年3月的某天董事会上,CFO告诉袁行远,公司账上欠了两千万,最多还有六个月的存活时间。说完这话后CFO辞职了,CTO徐涛也动摇了表示想离开公司。

开完董事会第二天,是北京的雾霾寒冬,整个园区几乎没有人。冒着被感染的风险,袁行远找到CTO徐涛,从下午一点谈话到凌晨一点,劝他不要走。聊公司要怎么自救,怎么接入更多广告商实现盈利。“在此之前融资非常顺,一切都很好,大家对世界的认知就是一年更比一年好。CEO可能也不怎么看账户余额。经历过疫情这个坎儿,才明白这个世界是随时可以Shut down(停转)的,这能让一个CEO看清泡沫之下的真相,做事留有余地,考虑不确定性。”袁行远认为这是他作为一个Old School创业者与新一波AI浪潮下的CEO最大的区别。

但这种谨慎和忧患心理,也让他在该全力投入时误入了迟疑与保守的错误方向。

那时,活下去成了彩云科技的头等目标,这让他们与Scaling law擦身而过,也造成了袁行远最大的遗憾。

2021年,他们训练出小梦第二代模型,发现参数变大的新模型产生了更好的效果。如果沿着Scaling law的路线,继续增大参数量训练,他们或许能够实现模型智能度的大幅提升。但当时有限的算力资源和疫情PTSD之下,不敢All in的他们放弃了继续扩大参数。袁行远回忆道:“这就像是看到了那扇新世界的大门,但是却没有走上前推开它。”(Scaling law:当模型参数、数据集规模和计算量越大,可以实现大模型性能的持续提升)

在GPT4.0发布后,看到OpenAI推开这扇门并走通了,从此OpenAI成为了大众眼中AI的代名词。他们花了很长时间消化这件事情,同时也必须要回答“接下来究竟走哪条路”的问题。肖达认为:“GPT4.0的破圈意味着所有AI公司都只有两条路可选,第一条路是调用打通OpenAI的API,另一条是自研模型。”

虽然自研模型并不能百分百成功,但袁行远对虎嗅表示:“如果放弃自研直接调用API,或者探索多模态等不同路径,并不能提升单位算力所提供的智能度,这些公司的价值存在依然完全依托于Transformer,并没有做出比Transformer性能更高的基础模型。”他要做一些与其他公司不同的事情。

掀开Transformer的盖头

2023年,彩云科技开始真正All in DCFormer。而GPT4的出现也给他们的工作定下了Deadline,必须要在一年时间把性能更优的模型成果拿出来。起初他们给自己定的目标是:通过改进Transformer架构提升一倍的效率。但那时他们觉得这是个“不可能完成的任务”——自2017年Transformer诞生的6年间,还没有一个人能做到。肖达对虎嗅坦言:“直到最后一刻他都不相信自己真的能做到,其中经历了很多像过山车一样起起伏伏的内心拉扯。”

但假如把目标降低,比如做到30%的提升,这样的工作相对来说更有把握,但30%的提升不足以说服开发者使用这个新的架构,因为换新架构意味着硬件优化和生态支持都需要从头做起,对开发者来说成本反而会提升,必须要做到一倍以上的性能提升才可能抵消这个成本。

最开始彩云科技算法团队想到了一个0到1搭建地基的架构改进基础路线,并发现这个想法跟Transformer主要作者之一Noam Shazeer的一篇改进注意力机制的论文思路很相似,于是他们决定在论文的基础上用自己的想法去复现,但最终效果相较原论文却大打折扣,这让他们感到绝望:“你做的工作别人已经做了,你去复现,你发现效果也没有那么好,你在干什么?”

但一次偶然的机会,他们发现一个重要的细节并扭转了局面:原论文路线的映射矩阵是低质的,假设一层有8个注意力头,这意味着并不需要用到此前的8×8矩阵。于是用8×2矩阵就实现了动态组合方案,而且效果反而比原论文用到的静态方案还要好很多,但速度仍然很慢。

所以他们继续改进,接下来的工作需要在小中大杯不同参数量的模型上跑通,来证明这个改进是能够scale-up(扩展到更大的模型上)的。但当扩展到中杯时,效果又大打折扣,这让他们开始担心会不会像很多其他架构改进的工作一样——在小模型上很有效但模型变大后失效。本来找到一丝希望的他们心又悬起来了。

于是又经历了一段漫长的调试过程。肖达告诉虎嗅:“通过2020年开始的分析Transformer模型可解释性工作,我们把Transformer从黑盒的某些部分变成白盒了。但是改进了架构之后变得比Transformer更为复杂,相当于又开了一个黑盒,所以我们只能做大量的实验来一点点改进。”

后来他数了一下实验次数,发现从小杯、中杯到大杯的测试实验团队总共尝试了500多次,终于在大杯上也实现了相同的效果提升。

这期间最大的挑战在于心态:“总是在反复地给你希望,又让你绝望过程中,但在以为走到死胡同时,又突然出现转机。”靠这些偶尔的正反馈,让他不知不觉地坚持到了最后。

在最后阶段性能优化时,他们把能试的靠谱方法都试了一遍,但都达不到理想效果,甚至想要求助其他学者。这也是因为:现在的模型优化研究以应用较为主流的GPU为主,关于彩云用的TPU优化研究资料很少。

他们又面临此前所有研究工作功亏一篑的可能性。走投无路时,他们用了一种反直觉的方法做了最后的尝试——类似flash attention的分块计算优化方法。当时他们并没抱太大希望,因为他们当时认为这个方法虽然简单,但是只会让速度更慢。出乎意料的是恰恰是这个方法让速度更快了,最终实现了理想效果。

另一个更为巧合的事情是:2023年GPU资源紧张,接触的一些算力提供商告诉他们,如果要拿卡可能要等三个月以上,所以他们用了TPU来训练,但最后回过头来看,他们发现假如一开始选择GPU训练,很可能在优化这一步卡住,最终做不出DCFormer。这个资源匮乏时被动的选择,反而在某种程度上成就了他们。

经历了这么多奇迹般的巧合之后,肖达发现了其中的使命感:“走到这一步,这个事情他冥冥之中就是需要你来做的,会有一种使命感。这个过程中假如有任何一环有所改变,都走不到这一步。如果这个世界有一个人能做到,那就只是你自己。”

不同于大部分创业者喜欢挂在嘴边的宏大AGI信仰,这种使命感支撑他走过了研发过程中的漫长黑夜。

2024年5月1号,肖达终于收到了论文被ICML 2024录用的消息,并拿了三个7分(平均分为4.25-6.33)的不错成绩。但这对他来说仍是稀松平常的一天。

几天后,肖达带着因研发错过两次团建的算法团队,去公司旁边的烤肉店庆祝,一向内敛的他也并没有说太多煽情的话。因为经历了那么多的研发挑战和心理波动后,他反而没有那么大的心力去兴奋喜悦,“成功的时候,你会发现自己已经很平静了。”

然而在发布会后与肖达交流中,我能感受到他的平静之下,仍保留着一些悬而未决的未知。他向我解释了ICML的论文构成:“一般会议会选出2~3%左右的论文作为Oral(演讲论文) ,其余的论文接受形式则是Poster(海报展示)。”显然Oral对于一个学术工作者意义非凡,但他并不确定论文能否拿到Oral——这是那时他最大的悬念。往年Oral结果会与论文投递结果同时通知,但今年的ICML不同,Oral结果迟迟没有公布。

出乎我意料的是,在6月5号,发布会的交流后一周,悬念揭晓。笔者看到了肖达的另一面,感受到他一反常态的激动与喜悦,他发微信告诉我:“彩云科技关于DCFormer研究的论文被ICML 2024接收为Oral了。”

ICML(国际机器学习大会)是国际机器学习领域的顶级会议,在AI浪潮下,今年这个领域尤为炙手可热,因此今年投递论文较往年数量陡增,评选标准更为严格,Oral的比例也从往年的前2.5%降至前1.5%,在投递给ICML的9473篇论文中,只有两篇来自中国企业投递的论文斩获Oral。除彩云外,另一家是华为。

这个结果并不在肖达意料之中:“虽然知道自己做的是有价值的工作,能得到同行的认可还是很开心。”毕竟,最开始他们是不相信自己能做成这件事情的。

7月份受邀去维也纳ICML2024登台演讲后,袁行远和肖达接下来还要继续做改进架构的工作,这次,他们的目标是在一年之内将DCFormer的性能再改进一倍。“只有模型效率和智能度提升,才能实现真正的AGI。”

文章来自于 “虎嗅”,作者 “王欣”

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则